歴史的転換:

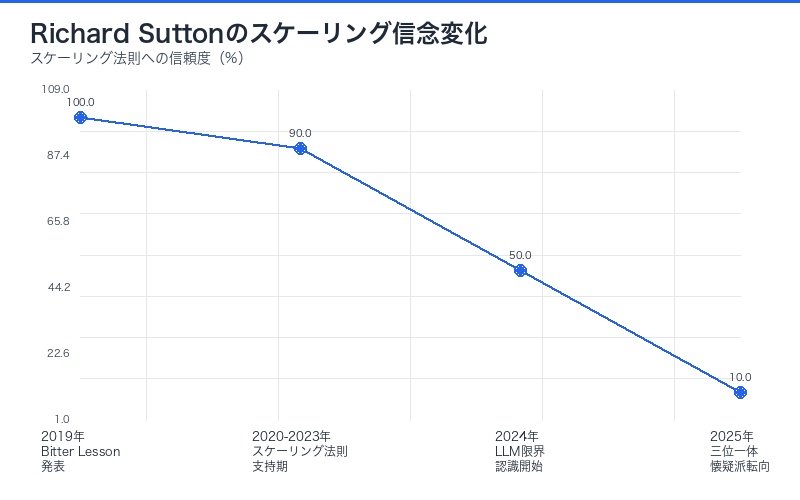

2025年9月、AI界に衝撃が走りました。「Bitter Lesson(苦い教訓)」の提唱者であり、スケーリングの信奉者とされてきたチューリング賞受賞者Richard Suttonが、LLMの純粋なスケーリングでは知性を達成できないと明言したのです。

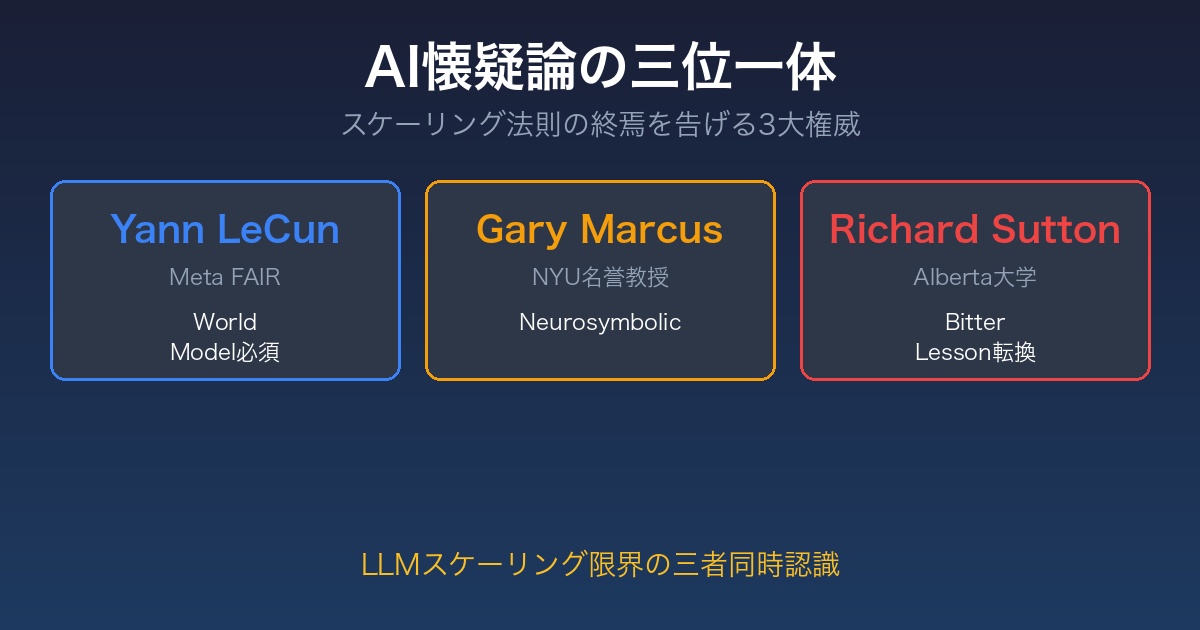

これにより、Yann LeCun、Gary Marcus、そしてRichard Suttonという「AI懐疑論の三位一体」が形成され、AGI達成への道筋が根本から問い直されています。

「懐疑論の聖なる三位一体」とは?

Kim Monismus氏がX(Twitter)で表現した「The holy trinity of skepticism」は、AI業界の潮流変化を象徴する言葉です。

The holy trinity of skepticism: Yann Lecun, Gary Markus, and now Richard Sutton.

— Chubby♨️ (@kimmonismus) 2025年9月27日

All joking aside: even though Gary and Yann are heavily criticized and I completely disagree with them, I think it’s good that they defend their arguments so vehemently.

Their skepticism about the scaling paradigm of LLMs forces us to question our own perspective even more and to look for arguments as to why LLMs (can) achieve AGI. In this respect: welcome, local trinity!

三位一体の構成メンバー

| 人物 | 肩書き | 主張の核心 | 提唱するアプローチ |

|---|---|---|---|

| Yann LeCun | Meta AI責任者 チューリング賞受賞者 |

LLMは人間レベルAIへの脇道 | 世界モデルベースのAI |

| Gary Marcus | AI研究者・起業家 | スケーリングだけではAGI不可 | ニューロシンボリックAI |

| Richard Sutton | 強化学習の父 チューリング賞受賞者 |

LLMは経験から学ばない | 強化学習ベースのAI |

なぜ「三位一体」が重要なのか

Kim Monismus氏の洞察:

「Gary(Marcus)とYann(LeCun)は激しく批判されており、私は彼らに完全に同意しないが、彼らが自分の主張を熱心に擁護するのは良いことだと思う。」

「LLMのスケーリングパラダイムに対する彼らの懐疑論は、私たち自身の視点をさらに疑問視し、LLMがAGIを達成できる(または達成する)理由についての議論を探すことを強いる。」

つまり、批判者の存在が、擁護派の主張をより強固にする「建設的対立」を生み出しているのです。

Richard Suttonの歴史的転換:Bitter Lessonの逆説

最も衝撃的なのは、Richard Suttonの立場変化です。

Bitter Lesson(苦い教訓)とは

2019年、Suttonは「The Bitter Lesson」という影響力のあるエッセイを発表しました。

核心的主張:

- AI進歩の歴史から得られる「苦い教訓」は、人間の知識を組み込むアプローチは常に失敗するということ

- 成功するのは、スケーリング(計算量の増大)に依拠する汎用的手法のみ

- 「大規模計算と共にスケールする汎用手法の偉大な力」を信じるべき

業界への影響:

このエッセイは、LLMのスケーリング研究を正当化する理論的支柱となり、OpenAI、Google、Anthropicなどの巨額投資の根拠とされました。

2025年の立場転換

しかし、2025年9月のDwarkeshポッドキャストで、Suttonは驚くべき発言をしました。

Suttonの新たな主張:

- LLMは世界モデルを持たない

「LLMは世界のモデルを持たず、目標も持たない。強化学習は世界を理解することだが、大規模言語モデルは人間を模倣すること、人がすべきだと言うことをすることだ。それらは何をすべきかを見つけ出すことではない。」

- Bitter Lessonへの自己矛盾

「大規模言語モデルは本当にBitter Lessonの事例なのか疑問だ。それらは明らかに大規模計算を使う方法だが、同時に大量の人間知識を組み込む方法でもある。」

- 経験学習の重要性

「スケーラブルな方法とは、経験から学ぶことだ。物事を試し、何が機能するかを見る。誰もあなたに教える必要はない。経験から学習できるシステムがあれば、はるかに優れたパフォーマンスを発揮し、よりスケーラブルになる可能性がある。その場合、それは別のBitter Lessonの実例となるだろう。人間知識を使うものは、最終的には経験と計算から訓練されるものに取って代わられた。」

Gary Marcusの反応

Astonishing. It’s been a long, hard, unpleasant road.

— Gary Marcus (@GaryMarcus) 2025年9月26日

But one by one, every major figure in AI has come around to the critique of LLMs that I began giving here in 2019.

@ylecun was first.

Sir @demishassabis sees it now, too.

Turing Award winnner @RichardSSutton, famous for the Bitter Lesson, is the latest to come around.

The only people left still pretending scaling LLMs is all you need are grifters.

Marcusの主張:

- 「驚くべきことだ。長く、困難で、不愉快な道のりだった」

- 「しかし次々と、AI界の主要人物全員が、私が2019年にここで始めたLLMの批判に賛同するようになった」

- 「純粋なLLMのスケーリングだけで十分だと偽っている唯一の人々は詐欺師だ」

Yann LeCunの一貫した批判:世界モデルの必要性

Meta AI責任者のYann LeCunは、早くからLLMの限界を指摘していました。

LeCunの主張

核心的批判:

- 「自己回帰的LLMは性能の天井に達している」

- 「LLMは有用だったが、人間レベルAIへの道の脇道だった」

- 「人間レベルAIに到達するには、新しいアーキテクチャと新しいパラダイムが必要だ」

世界モデルベースのアプローチ

LeCunが提唱するのは、「世界モデル」を中心とした新しいAI設計です。

世界モデルとは:

- 物理法則の理解:現実世界の因果関係を学習

- 予測能力:行動の結果を事前にシミュレーション

- 常識推論:明示的に教えられていない状況でも推論

- 効率的学習:少ないデータから多くを学ぶ

LLMとの違い:

| 観点 | LLM | 世界モデルベースAI |

|---|---|---|

| 学習対象 | テキストパターン | 世界の因果構造 |

| 推論方式 | 次トークン予測 | 内部シミュレーション |

| 常識理解 | 表面的 | 深い理解 |

| データ効率 | 低(大量データ必要) | 高(少量で学習) |

| AGI可能性 | 限定的 | 高 |

LeCunとMarcusの歴史的対立

両者はThreads上で激しい議論を展開しました。

争点:

- 「誰が最初にLLM限界を予測したか」

- Marcusは2019年から一貫してLLMの限界を主張

- LeCunは「歴史を書き換えようとしている」と反論

現在の状況:

対立は続いているものの、「純粋なLLMスケーリングではAGI不可能」という結論では一致しています。

Gary Marcusの予言と現実:Deep Learningの壁

Gary Marcusは、批判の嵐の中でも一貫してLLMの限界を主張し続けました。

2022年の予言論文

Marcusの2022年論文「Deep Learning is Hitting a Wall」の主張:

- スケーリング則は物理法則ではない

- 単なる経験的一般化に過ぎない

- 無限にスケールできるわけではない

- 純粋なスケーリングではAGI不可

- データと計算を増やすだけでは根本的限界を超えられない

- GPT-3の限界は、スケーリングでは解決不可能

- 構造的問題の存在

- 幻覚(Hallucination)

- 因果推論の欠如

- 常識理解の表面性

- 説明可能性の低さ

業界の嘲笑から検証へ

2022年当時の反応:

- Sam Altman(OpenAI CEO):明確な否定

- Greg Brockman(OpenAI共同創業者):嘲笑的反応

- Yann LeCun:批判的コメント

- Elon Musk:否定的反応

2025年の現実:

- Satya Nadella(Microsoft CEO):Marcusの主張をほぼそのまま繰り返す

- 業界コンセンサス:純粋スケーリングの限界を広く認識

- 検証結果:MarcusのGPT-3限界予測がほぼ的中

ニューロシンボリックAIの提案

Marcusが提唱するAGI達成への道:

ニューロシンボリックAIとは:

- ニューラルネット:パターン認識・学習能力

- シンボリック推論:論理的思考・因果推論

- 先天的制約:生得的な知識構造

- 統合アーキテクチャ:両者の長所を組み合わせ

期待される効果:

| 課題 | LLMの限界 | ニューロシンボリックの解決策 |

|---|---|---|

| 幻覚 | 事実と虚構を区別できない | 知識ベースとの照合 |

| 因果推論 | 相関を因果と誤認 | 因果グラフによる明示的推論 |

| 説明可能性 | ブラックボックス | 推論過程の可視化 |

| データ効率 | 大量データ必須 | 先天的知識で補完 |

Demis Hassabisも認めた限界:DeepMindの視点

Gary Marcusは、Google DeepMind CEOのDemis Hassabisも同様の認識に至ったと指摘しています。

Hassabisの現状認識

LLMに欠けている能力:

- 推論能力:論理的思考の深さ

- 階層的計画:複雑なタスクの分解・実行

- 長期記憶:持続的な学習と記憶

- 一貫性:タスク間での性能のばらつき

創造的発明能力の欠如:

「AGIの明確に欠けているベンチマークは、これらのシステムが科学に関する独自の仮説や推測を発明する能力であり、既存のものを証明するだけではない。今日のシステムは、そのような創造的、発明的能力からはまだかなり遠い。」

PhD レベルAI主張への反論:

Hassabisは、競合他社の「現代AIシステムがPhDレベルの知性を持つ」という主張を「ナンセンス」と一蹴しました。

DeepMindのAGIタイムライン

Hassabisの予測:

- 3-5年以内:50%の確率でAGI達成

- 5-10年以内:人間の全タスクで匹敵するAI

- 2025年達成:どの研究機関も不可能と断言

必要な技術革新:

- 継続学習(Continual Learning):オンラインコンテンツからの継続的学習

- 真の推論能力:現状のシステムでは不十分

- 創造的仮説生成:科学的発見に必要な能力

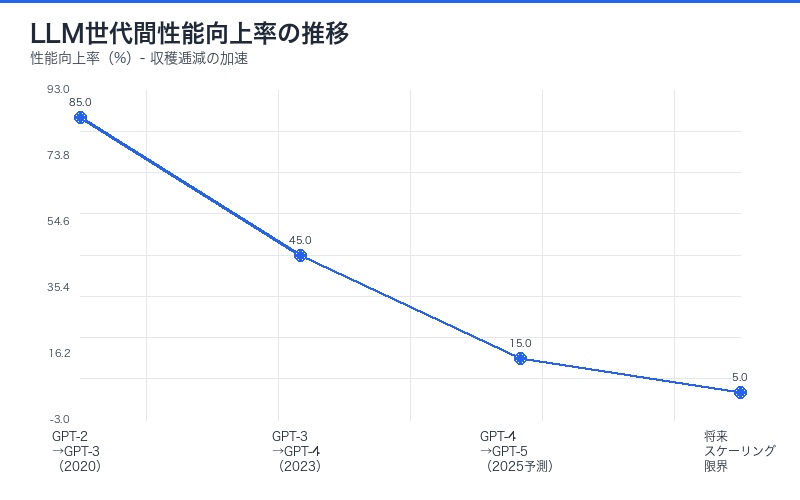

スケーリング則の限界:実証データ

スケーリング懐疑論を裏付ける実証データが蓄積されています。

OpenAIの「壁」

報告されている問題:

- コスト爆発:GPT-5訓練に推定200億ドル以上

- 性能の頭打ち:期待されたブレークスルーの不在

- データ枯渇:インターネット上の高品質データが底をつく

- エネルギー制約:電力供給が開発のボトルネック

業界全体の認識変化

Fortune誌の分析:

「AI業界で最も報道されていない重要な話は、純粋なスケーリングがAGI生成に失敗したことだ。」

主要企業の対応:

| 企業 | 従来アプローチ | 新戦略 |

|---|---|---|

| OpenAI | 純粋スケーリング | 推論最適化、マルチモーダル統合 |

| Google DeepMind | Transformer拡大 | AlphaFold型専門AI、世界モデル研究 |

| Meta | LLaMAスケール | 世界モデル、エージェント型AI |

| Anthropic | Constitutional AI | 解釈可能性研究、安全性第一設計 |

建設的懐疑論の価値:なぜ批判者が必要なのか

Kim Monismus氏が指摘するように、懐疑論者の存在は業界全体にとって有益です。

対立がもたらす進歩

1. 主張の精緻化

- 批判に応えることで、LLM擁護派も論理を強化

- 「なぜLLMでAGIに到達できるのか」の議論が深化

- 曖昧な期待が具体的な技術課題に変換される

2. リスクの可視化

- 過剰な期待値の是正

- 投資判断の健全化

- 技術的限界の早期認識

3. 代替アプローチの探索

- 世界モデル、ニューロシンボリック、強化学習の再評価

- ハイブリッドアプローチの模索

- 新しいパラダイムへの投資

「詐欺師」vs「革新者」の見極め

Gary Marcusの「純粋なLLMスケーリングで十分と偽る者は詐欺師」という発言は挑発的ですが、重要な問いを投げかけます。

見極めのポイント:

| 観点 | 「詐欺師」の特徴 | 「革新者」の特徴 |

|---|---|---|

| 限界の認識 | 限界を認めない | 率直に課題を議論 |

| タイムライン | 非現実的な短期予測 | 不確実性を含む慎重な予測 |

| 技術的詳細 | 曖昧な「ブレークスルー」宣言 | 具体的な技術課題と解決策 |

| 投資の透明性 | 誇張した期待値で資金調達 | リスクを明示した現実的計画 |

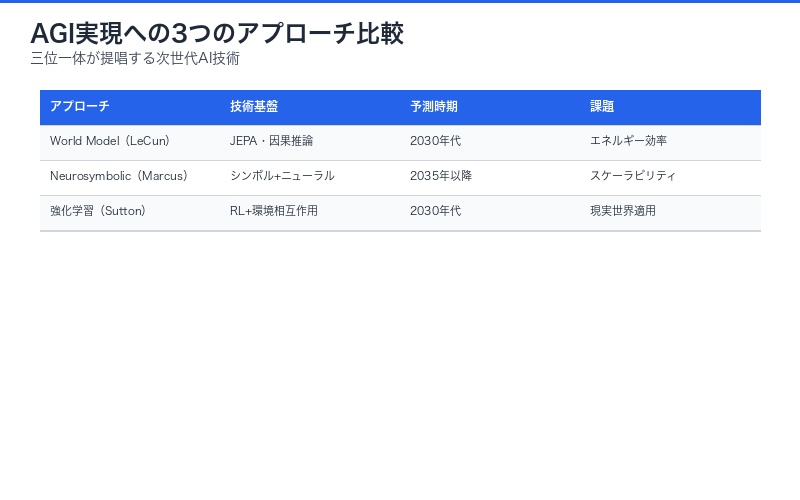

AGI達成への3つの道:三位一体が示す未来

Yann LeCun、Gary Marcus、Richard Suttonの見解を統合すると、AGI達成への道筋が見えてきます。

道筋1:世界モデルベースAI(LeCun派)

核心技術:

- 自己教師あり学習:ラベルなしデータから世界を学習

- 因果推論エンジン:行動の結果を予測

- 階層的表現:抽象度の異なる複数レベルでの理解

- エネルギーベースモデル:確率的ではなく決定論的推論

想定タイムライン:5-10年

道筋2:ニューロシンボリックAI(Marcus派)

核心技術:

- 知識グラフ統合:構造化された知識ベース

- 論理的推論エンジン:記号処理による厳密な推論

- 先天的バイアス:生得的な認知構造

- ハイブリッドアーキテクチャ:ニューラルと記号の最適結合

想定タイムライン:7-15年

道筋3:経験学習型AI(Sutton派)

核心技術:

- 深層強化学習:試行錯誤からの最適化

- 内発的動機付け:報酬設計なしでの探索

- メタ学習:学習方法自体を学習

- 継続的適応:環境変化への柔軟な対応

想定タイムライン:10-20年

最も有望なアプローチ:ハイブリッド統合

実際には、3つのアプローチの統合が最も現実的です。

統合アーキテクチャの例:

┌─────────────────────────────────────┐

│ 経験学習層(Sutton) │

│ 強化学習による継続的最適化 │

└──────────────┬──────────────────────┘

↓

┌─────────────────────────────────────┐

│ 世界モデル層(LeCun) │

│ 因果推論・シミュレーション │

└──────────────┬──────────────────────┘

↓

┌─────────────────────────────────────┐

│ ニューロシンボリック層(Marcus) │

│ 知識統合・論理的推論 │

└─────────────────────────────────────┘

各層の役割:

- ニューロシンボリック層:基盤的知識と論理推論

- 世界モデル層:環境理解とシミュレーション

- 経験学習層:継続的な最適化と適応

日本のAI戦略への示唆

この「懐疑論の三位一体」が示す教訓は、日本のAI戦略にも重要です。

避けるべき戦略

1. 純粋なスケーリング競争

- 米国・中国との計算資源競争は不可能

- 収穫逓減の法則により投資効率が悪化

- 電力・半導体制約で持続不可能

2. 単一アプローチへの集中

- LLMのみ、強化学習のみ、などの偏りは危険

- 技術的行き詰まりのリスク

- 多様性の欠如による革新の停滞

推奨される戦略

1. 差別化された技術開発

- 世界モデル研究:物理シミュレーション、ロボティクスでの強み活用

- ニューロシンボリック:論理的厳密性が求められる金融・医療分野

- ドメイン特化AI:製造業、材料科学などの得意分野

2. 多様なアプローチの並行研究

- 複数の有望技術に分散投資

- 産学連携による基礎研究強化

- 長期的視野での人材育成

3. 国際連携の戦略的活用

- 欧州の倫理重視AI研究との連携

- カナダの基礎研究機関との協力

- アジア諸国とのデータ・人材ネットワーク

具体的な行動計画

短期(1-2年):

- 世界モデル・ニューロシンボリック・強化学習の研究拠点設立

- 海外トップ研究者との共同プロジェクト開始

- ドメイン特化AIの商用化加速

中期(3-5年):

- ハイブリッドAIアーキテクチャのプロトタイプ開発

- 製造業・ロボティクスでの世界モデルAI実用化

- 医療・金融分野でのニューロシンボリックAI展開

長期(5-10年):

- 独自のAGIアプローチ確立

- 国際標準化への積極的関与

- AI技術の輸出産業化

まとめ:懐疑論がもたらす健全な進化

「AI懐疑論の三位一体」が示すのは、AGI達成への道が一本道ではないという現実です。

主要な教訓:

- スケーリングの限界:Bitter Lesson提唱者Suttonまでが認めた純粋スケーリングの行き詰まり

- 多様なアプローチの必要性:世界モデル、ニューロシンボリック、強化学習の統合が鍵

- 建設的対立の価値:懐疑論者の存在が業界全体の議論を深化させる

- ハイブリッドの時代:単一技術ではなく、複数アプローチの統合が最も有望

今後の展望:

- 2025-2027年:純粋LLMスケーリングからの脱却、新アーキテクチャ探索

- 2027-2030年:世界モデル・ニューロシンボリック・強化学習の統合実験

- 2030年以降:真のAGIに向けた複合システムの成熟

🔬 次のステップ:

AI開発者・研究者へのアクションアイテム:

- 視野を広げる:LLM以外のアプローチ(世界モデル、ニューロシンボリック、強化学習)を学ぶ

- 批判的思考:誇大広告と実際の技術進歩を見極める

- 長期視点:短期的なスケーリング競争ではなく、10年後の技術革新を見据える

- 協働:異なるアプローチの研究者と積極的に対話し、統合の可能性を探る

Yann LeCun、Gary Marcus、Richard Suttonという「懐疑論の三位一体」は、AI業界に健全な自己批判をもたらしました。彼らの批判は、一見ネガティブに見えますが、実際にはAGI達成への道をより確実なものにする建設的な貢献です。

純粋なスケーリングという「Easy Answer」に頼るのではなく、世界モデル、ニューロシンボリック、強化学習を統合した「Hard Answer」を追求する時が来ています。この困難な道こそが、真のAGIへの最短経路なのかもしれません。

コメント