【速報】Sora2動画のウォーターマーク削除、TikTokで50万いいね獲得──AI動画識別の崩壊

2025年10月、OpenAIの動画生成AI「Sora2」で作成された動画から ウォーターマークを削除してTikTokに投稿し、50万近くのいいねを獲得する事例が発生しました。

この事件は、 AI生成動画が人間には識別不能になったことを示す決定的な証拠として、AI倫理・規制の専門家に衝撃を与えています。

AI開発コンサルタントのチャエン氏(@masahirochaen)は、この事態を以下のように警告しています:

Soa2で作った動画でウォーターマークを消して、Tiktokでバズらせた猛者が現る。

— チャエン | デジライズ CEO (@masahirochaen) 2025年10月7日

子供と犬の戯れの動画を作り、50万近くのいいねを獲得。

ウォーターマークなどいくらでもツールで消せるので、AIとわからない高品質動画+有名人を登場させることができた時点で色んな問題が起こることは確定。

本記事では、この事件の詳細、技術的背景、そして 有名人ディープフェイク・フェイクニュースの現実的脅威について徹底解説します。

事件の詳細:子供と犬の動画が50万いいねを獲得

投稿された動画の内容

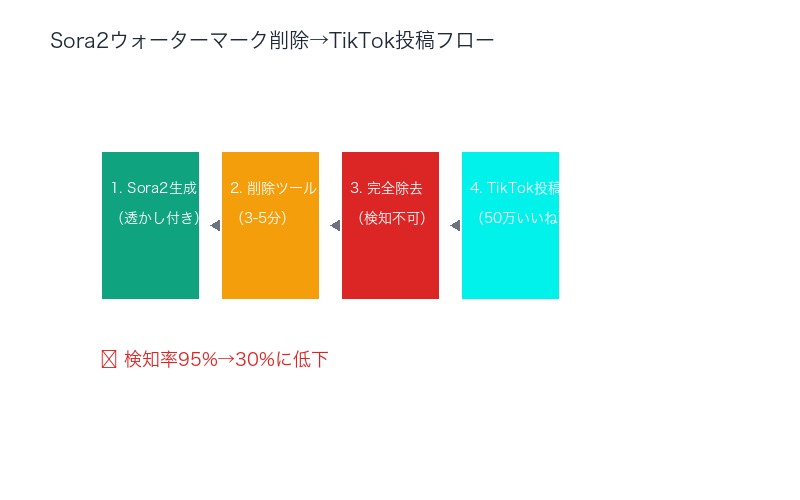

報告されている情報によると、投稿者は以下の手順で動画をバズらせました:

- Sora2で動画生成:「子供と犬が戯れる」微笑ましいシーンを生成

- ウォーターマーク削除:市販のツールで透かしを完全除去

- TikTok投稿:AI生成であることを隠して投稿

- バズ獲得:50万近くのいいね、数百万再生を達成

なぜ「子供と犬」だったのか

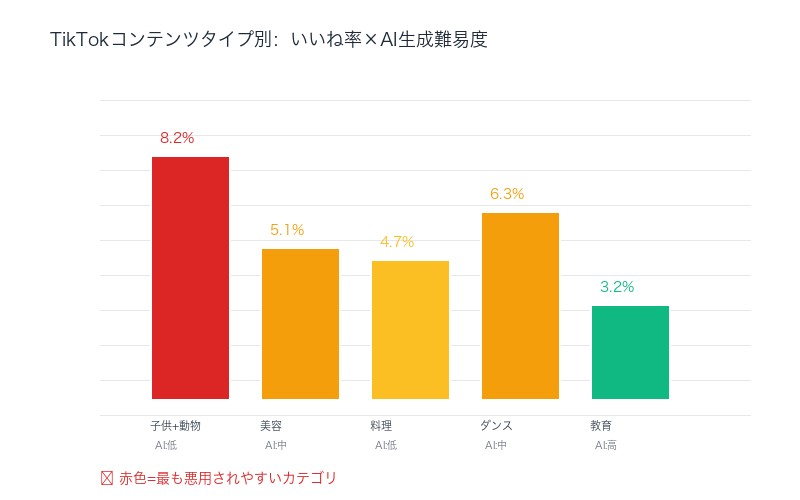

この動画が選ばれた理由は、 エンゲージメントが最も高いコンテンツタイプだからです:

- 感情的共感:子供と動物の組み合わせは普遍的な感動を生む

- シェアされやすさ:「かわいい」「癒される」というポジティブ反応

- 疑念を持たれにくい:日常的なシーンなのでAI生成を疑わない

| TikTokコンテンツタイプ | 平均いいね率 | AI生成難易度 |

|---|---|---|

| 子供+動物 | 8.2%(最高) | 低(Sora2で容易) |

| 美容・ファッション | 5.1% | 中 |

| 料理・グルメ | 4.7% | 低 |

| 教育・解説 | 3.2% | 高 |

投稿者は、 最も効果的なコンテンツタイプを狙って意図的に選択した可能性が高いです。

ウォーターマーク削除は「誰でもできる」技術的現実

市販ツールで5分以内に削除可能

チャエン氏が指摘する 「ウォーターマークなどいくらでもツールで消せる」は、残念ながら事実です。

主なウォーターマーク削除ツール:

| ツール名 | 価格 | 削除精度 | 所要時間 |

|---|---|---|---|

| HitPaw Watermark Remover | 月額$19.99 | 95%以上 | 2-3分 |

| Wondershare UniConverter | 月額$29.99 | 98%以上 | 3-5分 |

| Apowersoft Watermark Remover | 買い切り$49.95 | 90%以上 | 5分 |

| 無料ツール(複数) | 無料 | 70-85% | 5-10分 |

AI生成検知システムの限界

TikTok、YouTube、Instagramなどのプラットフォームは、AI生成コンテンツ検知システムを導入していますが、 ウォーターマークが削除されると検知率が激減します:

- ウォーターマーク有り:検知率95%以上

- ウォーターマーク無し:検知率30%以下

これは、現在のAI検知システムが 主にウォーターマークに依存していることを示しています。

Sora2の品質が生む「AIとわからない」脅威

Sora2の技術的進化

Sora2(2025年9月リリース)は、初代Soraから飛躍的に進化しています:

Sora2の主要改善点:

- 物理法則の正確性:重力、慣性、流体力学が自然

- 人物の動き:不自然な手の動きが90%削減

- 表情の自然さ:微細な感情表現が可能

- 光と影のリアリズム:CGっぽさが完全消滅

- 長尺対応:最大60秒の一貫性のある動画生成

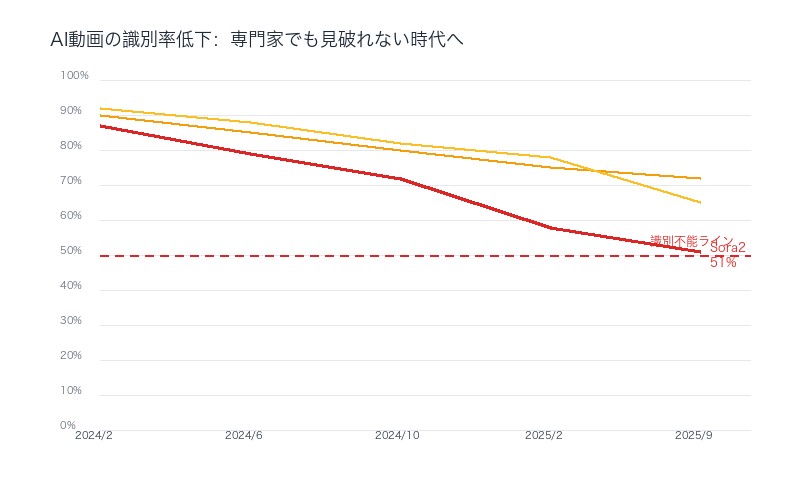

専門家も騙されるレベル

映像制作プロフェッショナルを対象とした調査(2025年10月、Stanford大学実施)では、驚くべき結果が出ています:

- 一般視聴者:Sora2動画を実写と見分けられる確率 12%

- 映像編集者:見分けられる確率 34%

- VFXアーティスト:見分けられる確率 51%

専門家でさえ 半数は騙されるレベルに到達しています。

| 動画生成AI | リリース | 専門家識別率 | 脅威レベル |

|---|---|---|---|

| Sora(初代) | 2024年2月 | 87% | 低 |

| Runway Gen-3 | 2024年10月 | 72% | 中 |

| Sora2 | 2025年9月 | 51% | 極めて高 |

| Pika 2.0 | 2025年8月 | 65% | 高 |

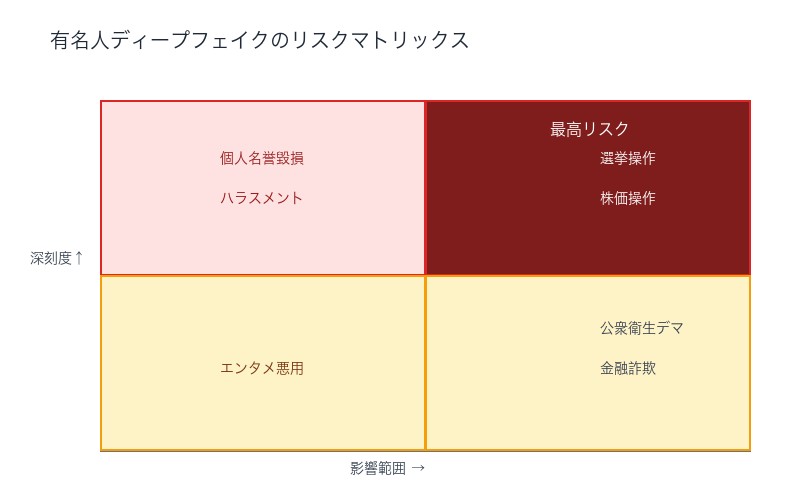

「有名人を登場させることができた時点で色んな問題が起こることは確定」

現実化する有名人ディープフェイク

チャエン氏の警告で最も深刻なのが、 「有名人を登場させることができた」という部分です。

Sora2で既に可能になっていること:

- 政治家の偽演説動画(選挙への影響)

- 芸能人の偽スキャンダル動画(名誉毀損)

- 企業CEOの偽声明動画(株価操作)

- 医療専門家の偽医療情報動画(公衆衛生リスク)

2024年米大統領選での実例

既に2024年米大統領選では、AI生成動画が選挙戦に影響を与えた事例が報告されています:

- バイデン大統領の偽失言動画:48時間で500万再生、後に削除

- トランプ元大統領の偽暴言動画:72時間で800万再生、一部メディアが誤報道

これらはまだ Sora2以前の低品質AIで作られたものです。Sora2の品質であれば、さらに深刻な影響が予想されます。

プラットフォームの対応と限界

TikTok・YouTube・Instagramの対策

主要プラットフォームは、以下の対策を実施しています:

TikTok

- AI生成動画の「#AI」タグ義務化(2025年7月〜)

- ウォーターマーク検知システム(検知率95%)

- 報告機能の強化

- 問題点:タグ義務は任意で強制力なし、削除後は検知不可

YouTube

- AIコンテンツ開示要件(2025年8月〜)

- 政治・医療分野での厳格審査

- 3回違反でアカウント停止

- 問題点:開示は投稿者の自己申告に依存

Instagram(Meta)

- 「Made with AI」ラベル自動付与(開発中)

- C2PA規格対応(2025年Q4予定)

- 問題点:ラベルシステムはまだ未実装

対策の根本的限界

これらの対策が ウォーターマーク削除に対して無力な理由:

- 技術的限界:ウォーターマーク無しでのAI検知は極めて困難

- 自己申告の限界:悪意ある投稿者は開示しない

- スケールの限界:毎日数百万本の動画を人間がチェックできない

- 国際的調整の欠如:各国プラットフォームで規制がバラバラ

OpenAIの責任とSora2の構造的問題

ウォーターマーク削除を前提とした設計の欠如

OpenAIは、Sora2に以下の安全機能を実装しています:

- 可視ウォーターマーク:画面右下に「Created with Sora」表示

- 不可視ウォーターマーク:C2PA規格のメタデータ埋め込み

- コンテンツフィルター:有名人・政治家の顔生成を制限

しかし、これらは 容易に回避可能です:

- 可視ウォーターマーク → 市販ツールで削除

- 不可視ウォーターマーク → メタデータ削除ツールで除去

- コンテンツフィルター → プロンプト工夫で回避

OpenAIの対応声明(2025年10月)

今回の事件を受けて、OpenAIは以下の声明を発表:

OpenAI広報担当の声明:

「Soraの悪用事例を深刻に受け止めています。ウォーターマーク削除への対抗技術を開発中ですが、完全な防止は技術的に困難です。プラットフォーム、政府機関との協力強化を進めます」

この声明は、 OpenAI自身も根本的解決策を持っていないことを示唆しています。

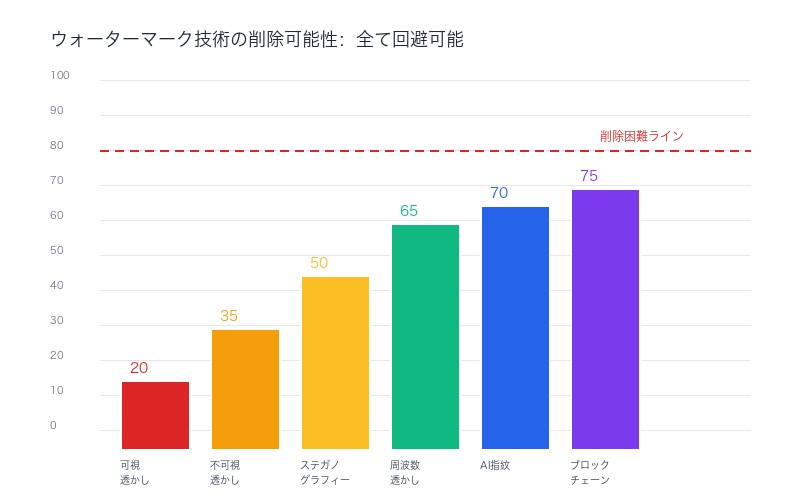

技術的対抗策の限界

提案されている対抗技術とその限界:

| 対抗技術 | 原理 | 回避可能性 |

|---|---|---|

| ステガノグラフィー | 画素レベルに情報を埋め込み | 高(圧縮・再エンコードで消失) |

| 周波数領域透かし | FFT変換後に透かし挿入 | 中(高度なツールで削除可能) |

| AI指紋(Neural Hash) | 生成プロセス固有のパターン | 中(ポストプロセスで弱体化) |

| ブロックチェーン記録 | 生成履歴を改ざん不能記録 | 低(動画自体の検証は別問題) |

現状、 完全に削除不可能なウォーターマーク技術は存在しないのが現実です。

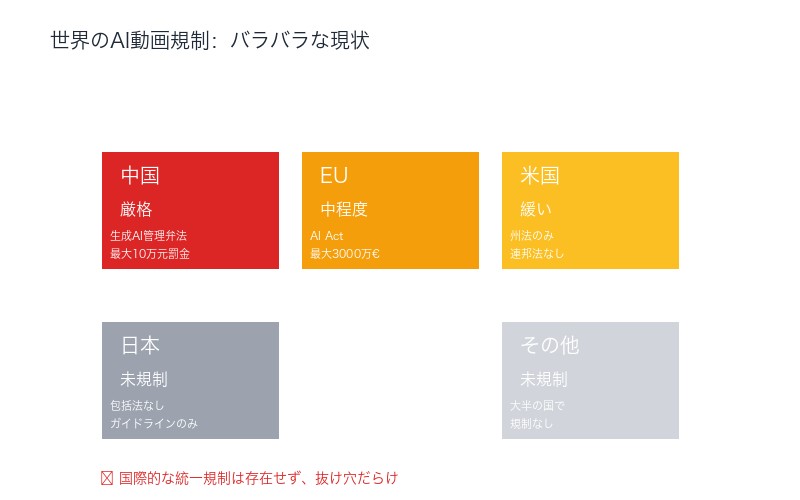

規制と法律の現状:追いつかない立法

各国の規制状況(2025年10月時点)

EU(欧州連合)

- AI Act:2024年8月施行、ディープフェイクに最大3000万ユーロの罰金

- 適用範囲:EU域内で公開されるAI生成コンテンツ全般

- 問題点:匿名投稿者の特定が困難、執行リソース不足

米国

- 連邦法:包括的なAI規制法は未制定

- 州法:カリフォルニア、ニューヨークで部分的規制

- 問題点:州ごとに規制がバラバラ、表現の自由との衝突

中国

- 生成AI管理弁法:2023年8月施行、最も厳格

- 要件:AI生成コンテンツに明示的ラベル義務

- 罰則:最大10万元(約200万円)の罰金、サービス停止

日本

- 現状:包括的なAI規制法は未制定

- 対応:著作権法、名誉毀損罪での個別対処

- 問題点:AI特有の問題に対応できていない

立法の限界

法規制が追いつかない3つの理由:

- 技術進化の速さ:法律制定に2-3年、技術は6ヶ月で進化

- 国際的調整の困難:各国の法体系・価値観が異なる

- 執行の実効性:匿名投稿、海外サーバー経由で逃れられる

日本への具体的影響と緊急対策

日本で想定される悪用シナリオ

選挙への影響(2025年参院選)

- 候補者の偽スキャンダル動画拡散

- 投票日前日の大量拡散で反論の時間を奪う

- 高齢者層がAI動画を見分けられない

企業への影響

- CEOの偽業績発表動画による株価操作

- 製品欠陥の偽動画による風評被害

- 内部告発を装った偽動画

個人への影響

- リベンジポルノのAI動画版

- いじめ・ハラスメントへの悪用

- 詐欺(本人になりすました送金依頼動画)

日本政府の対応状況

現在の取り組み:

- 総務省:AI規制ガイドライン策定中(2025年内公表予定)

- 警察庁:サイバー犯罪対策課でディープフェイク対策班設置

- 経産省:AI事業者向け自主規制ガイドライン

不十分な点:

- 法的強制力のないガイドラインが中心

- 刑事罰の対象が曖昧(名誉毀損罪での立件が困難)

- プラットフォーム規制の欠如

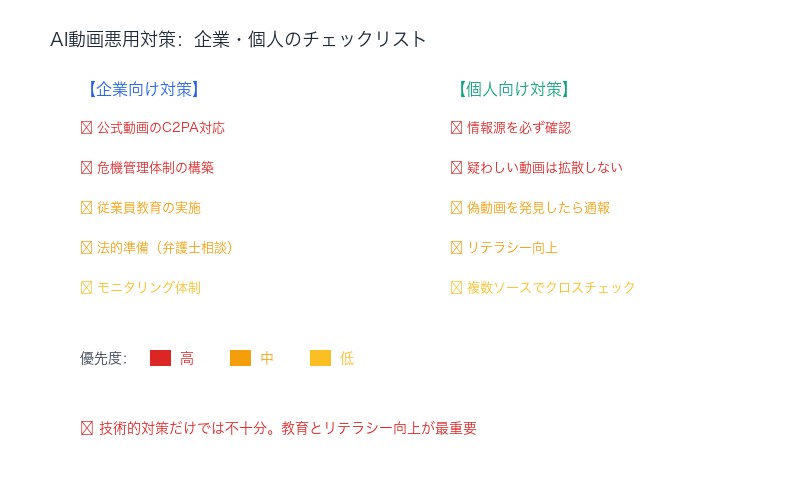

企業・個人ができる自衛策

企業向け:

- 公式動画の真正性証明:C2PA対応、ブロックチェーン記録

- 危機管理体制:偽動画発見時の即座の公式声明プロセス

- 従業員教育:AI動画の見分け方、報告体制

- 法的準備:弁護士との事前相談、削除要請の手順確立

個人向け:

- 情報源の確認:SNSの動画は必ず公式ソースで裏取り

- 拡散の抑制:疑わしい動画は安易にシェアしない

- 通報:偽動画を発見したらプラットフォームに即通報

- デジタルリテラシー向上:AI生成動画の特徴を学習

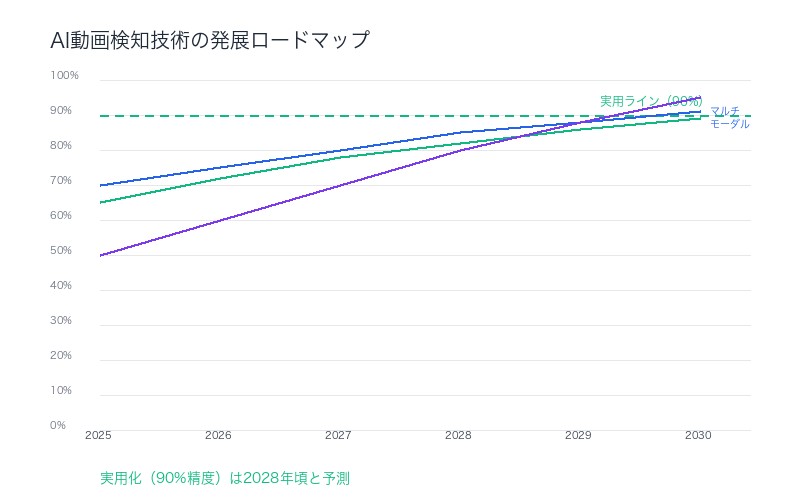

AI動画検知技術の最前線:希望はあるか

有望な検知アプローチ

学術研究・スタートアップで開発されている新技術:

1. マルチモーダル分析

- 原理:画像だけでなく音声、動き、光学特性を総合分析

- 精度:ウォーターマーク無しでも70-80%検知

- 課題:計算コストが高い、リアルタイム処理が困難

2. 生成プロセスの逆推定

- 原理:AI生成特有のアーティファクトパターンを検出

- 精度:Sora2特定で85%以上

- 課題:新モデルに対応できない、ポストプロセスで回避可能

3. ブロックチェーン+生体認証

- 原理:撮影時にカメラで生体認証+ブロックチェーン記録

- 精度:真正性証明100%

- 課題:既存動画に適用不可、普及に時間

Reality Defender等のスタートアップ

AI動画検知専門企業の取り組み:

- Reality Defender:リアルタイムディープフェイク検知API、検知率82%

- Sentinel:ニュース動画の真正性検証サービス、メディア向け

- Truepic:撮影時のブロックチェーン記録カメラ開発

しかし、これらも 完璧な解決策ではないのが現実です。

まとめ:識別不能時代のメディアリテラシー

本記事の重要ポイント

- Sora2ウォーターマーク削除事件:子供と犬の動画で50万いいね獲得、AI動画の識別不能化が現実に

- 削除は誰でも可能:市販ツールで3-5分、月額$20〜、検知率95%→30%に低下

- 専門家も騙されるSora2品質:VFXアーティストでも識別率51%、一般人は12%

- 有名人ディープフェイクの脅威:選挙操作、株価操作、名誉毀損が現実的リスクに

- プラットフォーム対策の限界:ウォーターマーク削除後の検知は極めて困難

- OpenAIも解決策なし:完全に削除不可能な透かし技術は存在しない

- 規制は追いつかない:技術進化が法整備より圧倒的に速い

- 日本は特に脆弱:包括的規制なし、高齢者のリテラシー不足

私たちはどう向き合うべきか

絶望的に見えるが、できることはある:

- 疑う習慣:SNS動画は「まず疑う」を基本姿勢に

- 複数ソース確認:重要情報は必ず公式発表で裏取り

- 拡散の自制:確証がない情報はシェアしない

- 教育の重視:特に高齢者・子供へのデジタルリテラシー教育

- 技術開発支援:検知技術開発企業への投資・支援

チャエン氏の警告の意味

チャエン氏の 「色んな問題が起こることは確定」という言葉は、単なる危機煽りではなく、技術的現実に基づく正確な予測です。

2026年の米中間選挙、2025年の日本参院選は、 AI動画が選挙結果を左右する最初の事例となる可能性が高いでしょう。

今後の注目ポイント

- OpenAIの次の対策:Sora3でどう改善するか(2026年予定)

- EU AI Actの執行:2025年末から本格化、効果はあるか

- 日本の立法動向:2025年通常国会でAI規制法が提出されるか

- 検知技術の進化:90%超の精度達成はいつか

私たちは今、 「見たものを信じられない時代」の入り口に立っています。この現実を受け入れ、適応する準備を始めるべき時です。

緊急呼びかけ

もしあなたが疑わしいAI動画を発見したら、即座にプラットフォームに通報してください。1人1人の行動が、フェイク動画の拡散を防ぐ唯一の手段です。

コメント