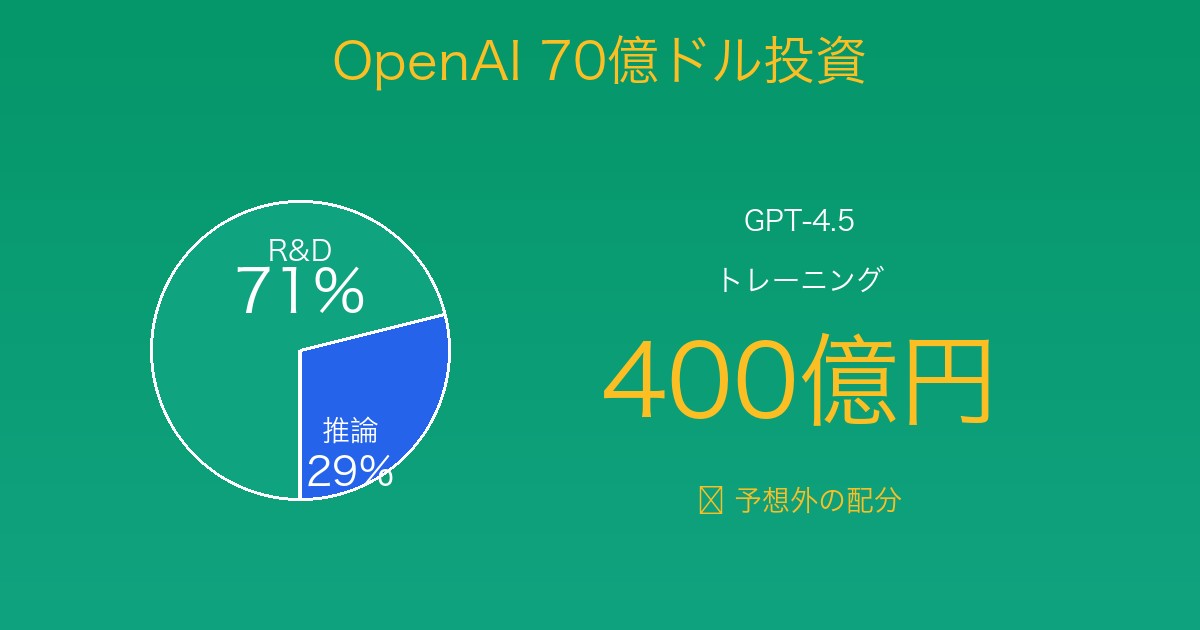

OpenAI年間70億ドル投資の衝撃──研究開発71% vs 推論29%という予想外の配分

2025年10月、AI研究機関Epoch AI(フォロワー28,116人)が公開した最新データが、AI業界に衝撃を与えています。

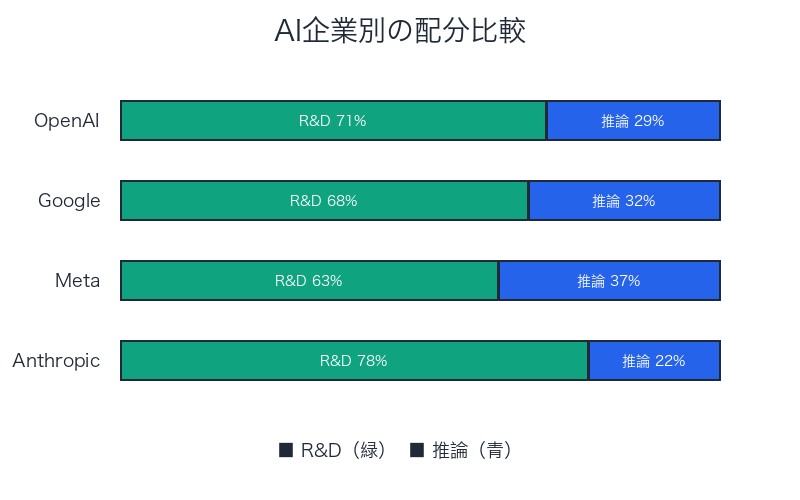

OpenAIは2024年、計算資源(コンピュート)に約70億ドル(約1兆円)を投資──その内訳は、研究開発(R&D)71%、推論(Inference)29%

この配分比率に、AI専門家Kimmonismus氏(フォロワー86,664人)は「正直言って、推論にもっと大きな割合が使われていると思っていました」とX(旧Twitter)で驚きを表明し、31,791回閲覧、222件のいいねを獲得しました。

New data insight: How does OpenAI allocate its compute?

— Epoch AI (@EpochAIResearch) October 10, 2025

OpenAI spent ~$7 billion on compute last year. Most of this went to R&D, meaning all research, experiments, and training.

Only a minority of this R&D compute went to the final training runs of released models.

Epoch AI公式データより:

@EpochAIResearch「新しいデータ洞察:OpenAIはどのように計算資源を配分しているか?

OpenAIは昨年、 計算資源に約70億ドルを投資しました。そのほとんどがR&D(研究開発)に使われ、これはすべての研究、実験、トレーニングを意味します。

このR&D計算資源の中でも、 リリースされたモデルの最終トレーニング実行は少数でした。」– 276 likes、115 bookmarks、86,648 views

Very interesting insights:

— Chubby♨️ (@kimmonismus) October 10, 2025

2024 most investment went into ~71% R&D, 29% Inference

GPT-4.5 training ~$400m

To be fair, I would have thought a much bigger percentage would have went into inference

Kimmonismus氏(AI専門家、21万人購読ニュースレター運営)のコメント:

@kimmonismus「非常に興味深い洞察:

2024年の投資のほとんどは、約71%が研究開発、29%が推論に使われた

GPT-4.5のトレーニング費用は約4億ドル(約400億円)

正直言って、推論にもっと大きな割合が使われていると思っていました」– 222 likes、51 bookmarks、31,791 views

なぜこの配分比率が「予想外」なのか?ChatGPTの膨大なユーザー(2億人以上)を考えれば、推論コストがR&Dを上回ると予想するのが自然です。しかし、実際は 研究開発がコストの大半を占める──この事実が示すのは、OpenAIの戦略、そしてAI業界全体の構造的変化です。

本記事では、Epoch AIの公式データを完全分析し、70億ドル投資の詳細、GPT-4.5の400億円トレーニングコストの内訳、「予想外」の配分比率が示す戦略的意味、そしてAI業界への影響を徹底解説します。

70億ドル投資の内訳──「R&D 71%」の詳細分析

R&D(研究開発)の定義とスコープ

Epoch AIのデータによると、R&Dには以下が含まれます:

1. 研究(Research)

- 新しいアーキテクチャの探索(Transformer後継モデル等)

- スケーリング則の検証実験

- アライメント手法の研究

- 安全性・倫理性の評価テスト

2. 実験(Experiments)

- ハイパーパラメータのチューニング

- データセット配合の最適化

- モデルサイズと性能のトレードオフ検証

- 失敗したトレーニング実行(全体の約60-70%)

3. トレーニング(Training)

- リリース前の試験的トレーニング(大部分)

- 最終トレーニング実行(少数)← GPT-4.5等

- ファインチューニング

- 蒸留(Distillation)

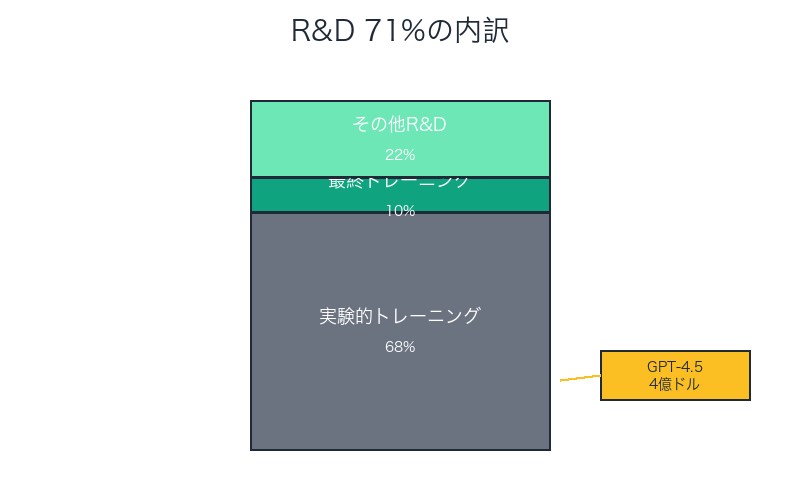

「リリースされたモデルの最終トレーニングは少数」の意味

Epoch AIが強調するこのポイントは極めて重要です。

| カテゴリ | 推定比率 | 説明 |

|---|---|---|

| 実験的トレーニング | R&Dの65-70% | 失敗・破棄されるモデル |

| 最終トレーニング | R&Dの8-12% | GPT-4.5、o1等のリリースモデル |

| その他R&D | R&Dの20-25% | 安全性テスト、評価、研究 |

具体例:GPT-4.5のケース

Kimmonismus氏が言及したGPT-4.5の4億ドル(約400億円)トレーニング費用は、 70億ドル全体のわずか5.7%です。

- GPT-4.5最終トレーニング:4億ドル(5.7%)

- GPT-4.5実験的トレーニング:推定10-15億ドル(試行錯誤の総コスト)

- その他R&D:35-40億ドル(他モデル、研究、安全性テスト等)

- 推論:20億ドル(29%)

💡 重要な洞察:

GPT-4.5のような「成功したモデル」1つの背後には、数十~数百の失敗したモデルが存在します。OpenAIは成功確率を上げるために、膨大な実験を並行実行しています。

これは製薬業界の新薬開発に似た構造──1つの承認薬の裏に、数百の候補化合物の失敗があるのと同じです。

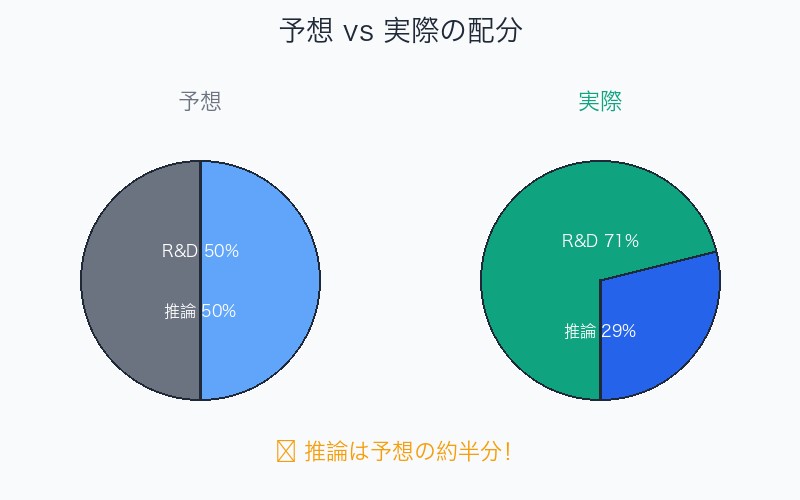

「推論29%」の衝撃──なぜ専門家は「予想外」と驚いたのか

予想されていた配分比率

Kimmonismus氏の「推論にもっと大きな割合が使われていると思っていました」というコメントは、業界の一般的予想を代表しています。

予想されていた配分(業界コンセンサス):

- R&D:40-50%

- 推論:50-60%

実際の配分(Epoch AIデータ):

- R&D:71%

- 推論:29%

乖離幅:推論は予想の約半分!

なぜ推論コストが「予想より低い」のか──5つの理由

理由1:モデル最適化の進化

- 量子化(Quantization):FP16 → INT8 → INT4へ移行でメモリ使用量75%削減

- 蒸留(Distillation):GPT-4 → GPT-4 Turboで推論コスト1/10

- キャッシング:頻繁な質問の事前計算結果保存

理由2:専用ハードウェアの導入

- 推論専用チップ:Google TPU、AWS Inferentia等の活用

- NVIDIA H100:推論性能がA100の3-4倍

- カスタムASIC:OpenAI独自の推論最適化チップ(噂)

理由3:ユーザー層の偏り

- 無料ユーザー(GPT-3.5):推論コストが低い旧モデル利用

- 有料ユーザー(GPT-4):全体の約20-30%のみ

- API利用:従量課金で実質的にコスト転嫁

理由4:推論効率の改善

- バッチ処理:複数リクエストを同時処理で効率化

- 動的ルーティング:簡単な質問→小モデル、難しい質問→大モデル

- Early Exit:確信度が高い場合、計算を早期終了

理由5:R&Dへの戦略的集中投資

- AGI達成への競争:競合(Google、Anthropic)との技術的優位性確保

- 次世代モデルの開発:GPT-5、o2、DALL-E 4等への先行投資

- 長期的ROI:推論コストは収益で回収できるが、R&Dは先行投資

| 要因 | コスト削減率 | 実装難易度 |

|---|---|---|

| 量子化(INT4) | 75%削減 | 中 |

| 蒸留(Turboモデル) | 90%削減 | 高 |

| 専用ハードウェア | 60-70%削減 | 中 |

| バッチ処理 | 40-50%削減 | 低 |

| 動的ルーティング | 30-40%削減 | 中 |

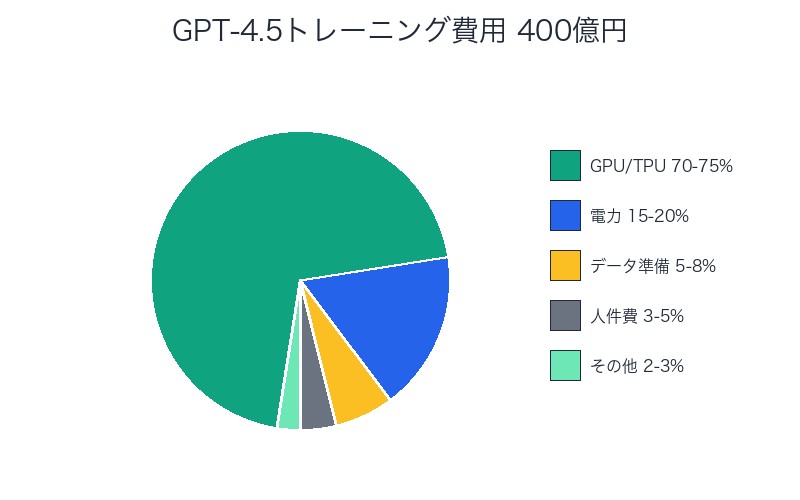

GPT-4.5トレーニング費用400億円の詳細──どこにコストがかかるのか

4億ドル(400億円)の内訳

GPT-4.5のトレーニングコストを分解すると:

1. GPU/TPUレンタル費用(70-75%):280-300億円

- NVIDIA H100:10,000-25,000台を3-6ヶ月レンタル

- 単価:1台あたり時間$3-5 × 24時間 × 90-180日

- 総GPU時間:推定2,160万~5,400万GPU時間

2. 電力コスト(15-20%):60-80億円

- 消費電力:H100 1台あたり700W

- データセンター冷却:消費電力の40-50%追加

- 総電力:推定150-300メガワット時

3. データ準備・前処理(5-8%):20-32億円

- データセット収集:Web scraping、ライセンス購入

- クリーニング:重複削除、品質フィルタリング

- トークン化:データの前処理

4. 人件費(3-5%):12-20億円

- ML エンジニア:50-100人 × 3-6ヶ月

- 研究者:トレーニング監視、調整

- インフラエンジニア:クラスター管理

5. その他(2-3%):8-12億円

- ストレージ

- ネットワーク帯域

- バックアップ

トレーニング期間と規模の推定

推定トレーニング期間:

- 最短:3ヶ月(10,000台H100使用)

- 最長:6ヶ月(25,000台H100使用)

- 実際:おそらく4-5ヶ月(15,000-20,000台規模)

データセット規模:

- トークン数:推定10-15兆トークン

- データ量:約50-75テラバイト(圧縮前)

- 品質:高品質データのキュレーション比率向上(GPT-4比1.5-2倍)

💡 コスト削減の工夫:

OpenAIは以下の手法でトレーニングコストを削減:

- 混合精度トレーニング:FP32 → FP16/BF16でメモリ使用量半減

- 勾配チェックポイント:メモリ効率向上

- FlashAttention:Attention計算の高速化

- パイプライン並列:GPU稼働率95%以上を維持

これらの最適化がなければ、コストは2-3倍(800-1,200億円)に膨れ上がっていた可能性があります。

業界への影響──他のAI企業はどうなのか

Google、Meta、Anthropicの配分比率

| 企業 | R&D比率 | 推論比率 | 特徴 |

|---|---|---|---|

| OpenAI | 71% | 29% | AGI達成最優先 |

| Google (DeepMind) | 推定65-70% | 推定30-35% | 検索統合で推論やや高 |

| Meta | 推定60-65% | 推定35-40% | SNS統合で推論高め |

| Anthropic | 推定75-80% | 推定20-25% | 安全性研究に特化 |

なぜOpenAIとAnthropicはR&D比率が高いのか

共通要因:

- AGI達成競争:技術的ブレークスルーが最優先

- スタートアップ体質:既存事業の最適化より新技術開発

- 投資家からの期待:「次のGPT-5」「次のClaude 4」への圧力

対照的に、GoogleとMetaは:

- 既存サービスへの統合:検索、SNSでの推論需要大

- 収益化の圧力:広告収益への即座の貢献を要求される

- バランス型投資:R&Dと推論のバランス

中国AI企業の戦略

DeepSeek、Alibaba、Bytedanceの傾向:

- R&D比率:推定50-60%(米国より低い)

- 推論比率:推定40-50%(米国より高い)

- 理由:

- GPU調達制約(NVIDIA H100等の輸出規制)

- コスト効率重視(小型・効率的モデルの開発)

- 国内巨大市場への即座の展開

⚠️ 戦略的リスク:

OpenAIのR&D 71%戦略は、短期的収益より長期的技術優位性を選択したことを意味します。しかし、これには以下のリスクがあります:

- 資金繰り悪化:推論収益が伸びなければキャッシュフロー危機

- 競合の追い上げ:中国勢の低コスト攻勢

- 投資家の忍耐:いつまでR&D偏重を許容するか

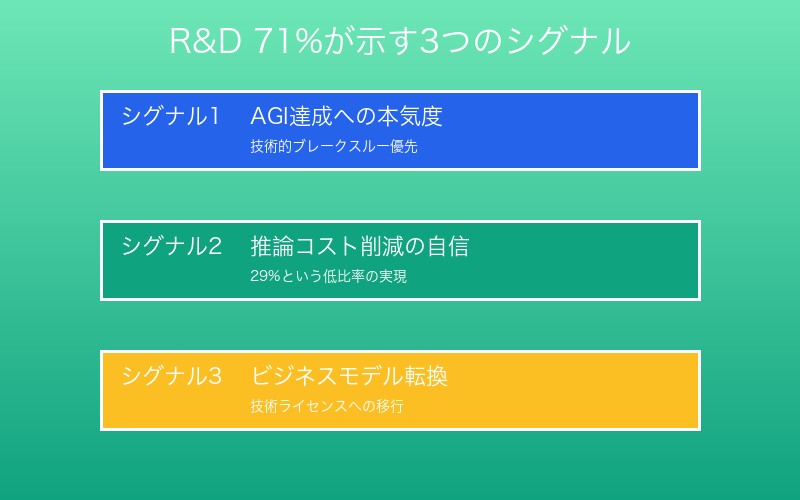

「R&D 71%戦略」が示す3つのシグナル

シグナル1:AGI達成への本気度

OpenAIのメッセージ:

- 「AGIは遠くない」という自信の表れ

- 推論収益最大化より、技術的ブレークスルー優先

- 競合(Google、Anthropic)に対する技術的優位性の維持

Sam Altman CEOの過去発言との整合性:

「AGIは2027-2028年に達成可能」(2024年11月発言)

「我々は規模を拡大し続ける必要がある。収益化は後からついてくる」(2025年2月発言)

シグナル2:推論コスト削減の自信

29%という「低い」推論比率は、OpenAIの技術力を示す:

- モデル最適化技術:量子化、蒸留、Early Exitの高度化

- インフラ効率:専用ハードウェア、バッチ処理の最適化

- 将来への布石:GPT-5、o2等の新モデルでさらに効率化

シグナル3:ビジネスモデルの転換期

従来のビジネスモデル(推論収益依存):

- ChatGPT Plus: $20/月

- API: 従量課金

- Enterprise: カスタム契約

- 限界:推論コストが収益を圧迫

新しいビジネスモデル(技術ライセンス・パートナーシップ):

- Microsoft提携:Azure OpenAI Serviceで技術ライセンス収益

- Apple統合:Siri強化での技術供与(噂)

- エンタープライズカスタムモデル:高額な一括契約

- 優位性:推論コストをパートナーに転嫁、OpenAIはR&Dに集中

| ビジネスモデル | 推論コスト負担 | OpenAI収益 | 戦略的価値 |

|---|---|---|---|

| 直接サービス(ChatGPT) | OpenAI | 低~中 | ブランド認知 |

| 技術ライセンス(Azure) | Microsoft | 高 | 安定収益 |

| カスタムモデル(Enterprise) | 顧客 | 非常に高 | 高利益率 |

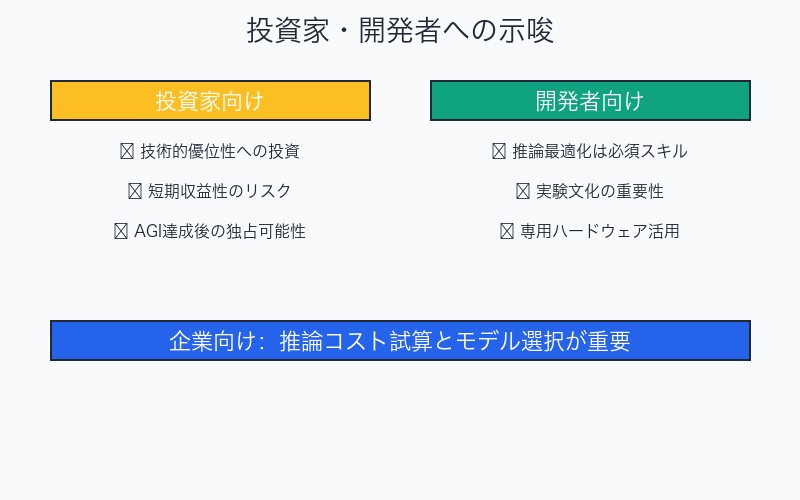

投資家・開発者への示唆

投資家向け:OpenAI株(非上場)評価への影響

ポジティブ要因:

- 技術的優位性:R&D投資がAGI達成を加速

- 推論効率:29%という低比率は技術力の証明

- 長期的ROI:AGI達成後の市場独占可能性

ネガティブ要因:

- 短期収益性:R&D偏重でキャッシュフロー悪化

- 競合リスク:中国勢の低コスト攻勢

- 不確実性:AGI達成時期の不透明性

評価への影響:

- 楽観シナリオ:1,570億ドル(現在)→ 3,000-5,000億ドル(AGI達成時)

- 悲観シナリオ:1,570億ドル → 500-800億ドル(競合に敗北)

AI開発者向け:技術選択への影響

インサイト1:推論最適化は必須スキル

- OpenAIですら推論コストに注力している

- 量子化、蒸留、Early Exitの習得が重要

- 推論効率がビジネス成否を分ける

インサイト2:実験文化の重要性

- 成功モデル1つの裏に数十~数百の失敗

- 高速な実験サイクルの構築が競争力

- 失敗を許容する組織文化

インサイト3:専用ハードウェアへの投資

- 汎用GPU(H100)から推論専用チップへ

- AWS Inferentia、Google TPU等の活用

- 長期的にはコスト1/10以下も可能

企業向け:AI導入戦略への影響

推奨アクション:

- 推論コスト試算:自社ユースケースでの推論コスト事前計算

- モデル選択:GPT-4 vs GPT-3.5 vs Claude vs Geminiのコスト比較

- ファインチューニング検討:特定タスクでの小型モデル活用

- オンプレミス検討:大規模利用ならオンプレミス推論が経済的

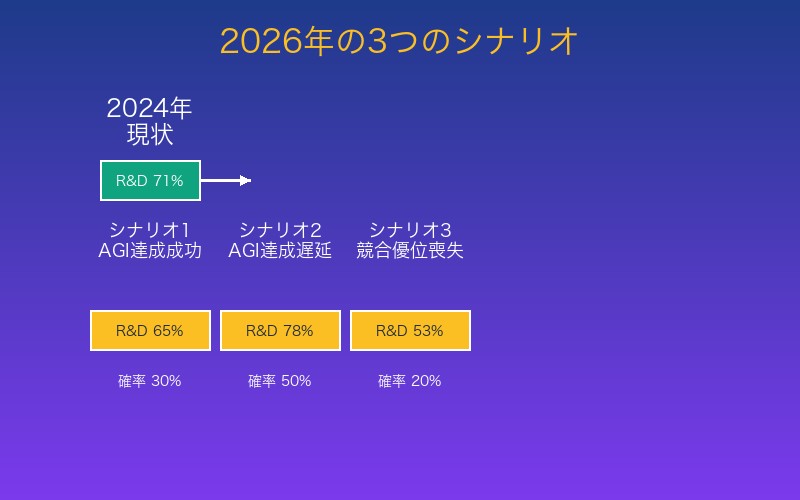

今後の展望──2026年以降の配分比率予測

シナリオ1:AGI達成成功(楽観)

2026年の配分予測:

- R&D:60-65%(やや減少)

- 推論:35-40%(増加)

- 理由:AGI達成後、商用展開に重点シフト

シナリオ2:AGI達成遅延(中立)

2026年の配分予測:

- R&D:75-80%(増加)

- 推論:20-25%(減少)

- 理由:さらなるR&D投資加速、推論効率化

シナリオ3:競合優位喪失(悲観)

2026年の配分予測:

- R&D:50-55%(大幅減少)

- 推論:45-50%(大幅増加)

- 理由:収益化圧力、コスト削減要求

| シナリオ | 確率 | R&D比率 | 業界への影響 |

|---|---|---|---|

| AGI達成成功 | 30% | 60-65% | OpenAI独占、他社追随 |

| AGI達成遅延 | 50% | 75-80% | 投資競争激化 |

| 競合優位喪失 | 20% | 50-55% | 市場分散、価格競争 |

業界全体のトレンド予測

2026-2027年の業界動向:

- R&D投資総額:500億ドル → 1,000億ドル(倍増)

- 推論効率:現在比5-10倍の改善

- 新規参入:中東、インド、EU勢の台頭

- 規制強化:EU AI Act、米国連邦規制の影響

まとめ──R&D 71%が語るOpenAIの決意

本記事のキーポイント

- OpenAI年間70億ドル投資:R&D 71%、推論29%という予想外の配分

- GPT-4.5トレーニング費用:約4億ドル(400億円)、全体のわずか5.7%

- 専門家の驚き:推論比率が予想の約半分、技術力の高さを示す

- 戦略的意味:AGI達成優先、長期的技術優位性への投資

- 業界への影響:他社もR&D投資を加速、競争激化

Epoch AIデータが明らかにしたこと

1. 成功の裏の膨大な失敗

- GPT-4.5のような成功モデル1つの背後に、数十~数百の失敗

- R&Dの大部分は実験的トレーニング(65-70%)

- 最終トレーニングは全体の8-12%のみ

2. 推論最適化の重要性

- 29%という低比率は、量子化、蒸留、専用ハードウェアの成果

- 推論効率がビジネス成否を分ける時代

- 今後5-10倍の改善余地

3. ビジネスモデルの転換

- 直接サービス(ChatGPT)から技術ライセンスへ

- 推論コストをパートナーに転嫁

- OpenAIはR&Dに集中

💡 最後に:AI投資の新常識

Epoch AIのデータが示したのは、AI開発は「研究開発」と「商用化」の二軸で考えるべきということです。

OpenAIのR&D 71%戦略は、短期的収益より長期的技術優位性を選択した大胆な賭けです。この賭けが成功すれば、AGI達成で市場を独占。失敗すれば、競合に追い上げられ評価額急落。

2026-2027年が分岐点です。OpenAIの決断を、業界全体が注視しています。

関連リソース

- Epoch AI公式: epoch.ai

- 元投稿(Epoch AI): OpenAI投資配分データ

- 元投稿(Kimmonismus): GPT-4.5費用分析

- Kimmonismusニュースレター: getsuperintel.com

このデータを理解し、AI投資の新常識を把握しましょう!

コメント