“Over 800 public figures, including “AI godfathers” and Steve Wozniak, sign open letter to ban superintelligent AI”?

— Chubby♨️ (@kimmonismus) October 23, 2025

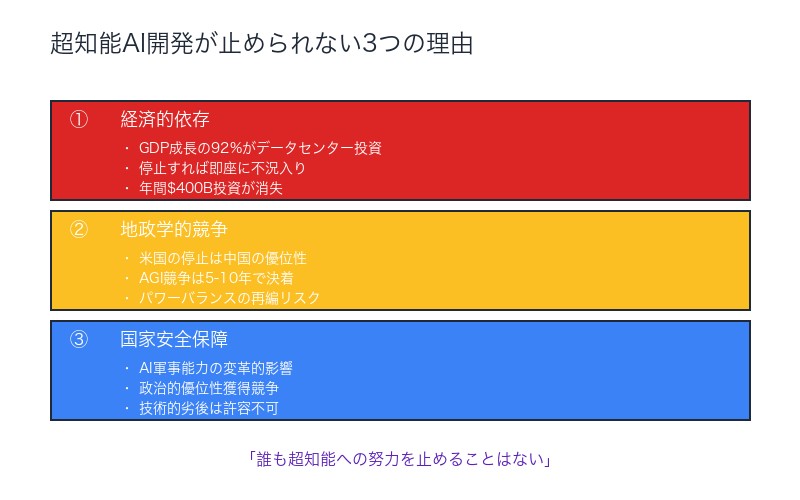

It’s too late, that won’t happen. Here are a few reasons why:

– Currently, all economic growth in the US is based on data center CapEx. Without these investments, the country would be in recession. What’s more, these investments will also have to pay off in the future. A pause? Impossible.

– Even if the US said it was taking a break, that would be a strategic advantage for China—to catch up with and overtake the US as quickly as possible. In short: a break for one party would be an advantage for the other.

– Furthermore, AI has long been declared strategic for national security; global competition will use AI to gain political advantages.

In summary: no one will stop striving for superintelligence. There is no doubt about that. pic.twitter.com/6SEYta9yQO

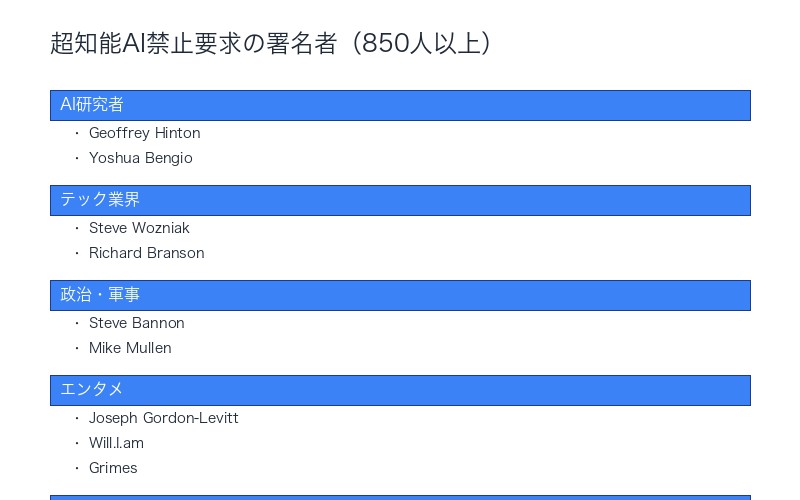

2025年10月、テクノロジー業界に衝撃が走った。AI研究の第一人者Geoffrey Hinton氏とYoshua Bengio氏、Apple共同創業者Steve Wozniak氏、Virgin Group創業者Richard Branson氏、さらにはPrince HarryとMeghan夫妻まで── 850人以上の著名人が超知能AI開発の禁止を求める公開書簡に署名したのだ。

しかし、この歴史的な呼びかけに対し、経済の現実は冷酷な答えを突きつける。 「もう遅すぎる。それは起こらない」──この主張を裏付けるのは、驚愕の経済データだ。

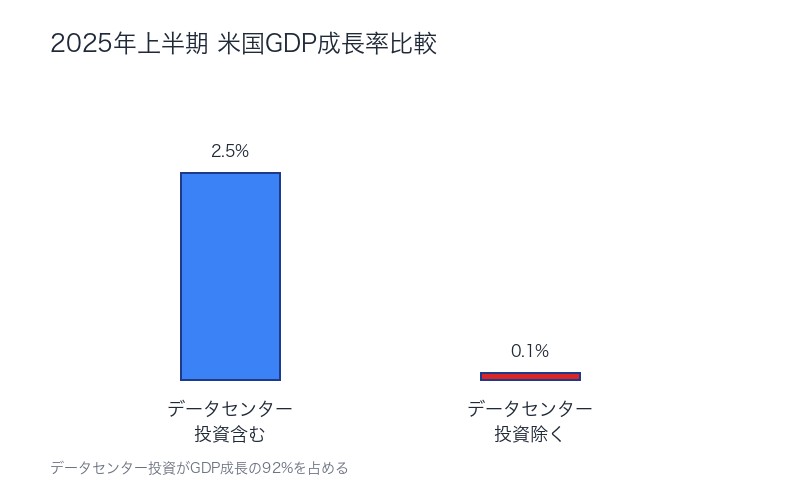

2025年上半期、データセンター投資を除いた米国のGDP成長率はわずか0.1%。ハーバード大学の経済学者Jason Furman氏が明らかにした数字は、米国経済がデータセンター投資に完全に依存している衝撃的現実を示している。

年間4000億ドル近い投資、GDP成長の92%を占めるデータセンター建設、そして激化する米中AI覇権競争──この記事では、なぜ超知能AI開発の停止が「不可能」なのか、3つの理由を徹底分析する。

850人の署名:AI Godfathersから王族まで集結した超知能AI禁止要求

Future of Life Institute (FLI)が2025年10月に公開した 「Statement on Superintelligence(超知能に関する声明)」は、過去に例を見ない規模と多様性を持つ警告となった。

署名者リスト:テック界のレジェンドから政治、王族まで

AI研究の第一人者:

- Geoffrey Hinton – 「AI Godfather」、2018年チューリング賞受賞者、元Google副社長

- Yoshua Bengio – 「AI Godfather」、2018年チューリング賞受賞者、モントリオール大学教授

テクノロジー業界:

- Steve Wozniak – Apple共同創業者

- Richard Branson – Virgin Group創業者

政治・軍事:

- Steve Bannon – 元トランプ大統領首席戦略官

- Mike Mullen – 元統合参謀本部議長

エンターテインメント:

- Joseph Gordon-Levitt – 俳優

- Will.I.am – ミュージシャン

- Grimes – ミュージシャン

王族:

- Prince Harry & Meghan – サセックス公爵夫妻

書簡の核心:「広範な科学的コンセンサス」まで開発禁止

FLIの声明は極めてシンプルかつ明確だ:

超知能開発の禁止を要求する。

この禁止は、以下の条件が満たされるまで解除されるべきではない:

- 安全かつ制御可能に開発できるという広範な科学的コンセンサスの確立

- 強力な公的支持(strong public buy-in)の獲得

– Future of Life Institute「Statement on Superintelligence」より

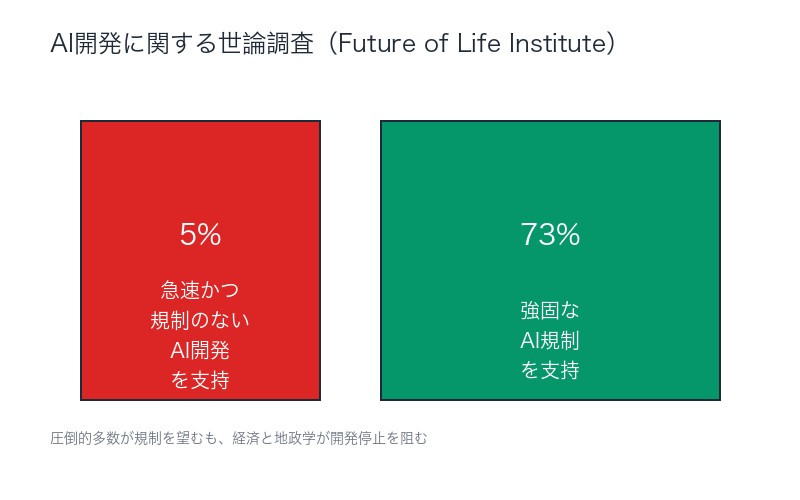

世論調査が示す圧倒的な規制支持:73% vs 5%

FLIが実施した世論調査は、一般市民の懸念を明確に示している:

| 立場 | 支持率 | 内容 |

|---|---|---|

| 強固な規制支持 | 73%以上 | AI開発に対する「強固な(robust)」規制措置を支持 |

| 急速な開発支持 | わずか5% | 急速かつ規制のない先進AIツール開発を支持 |

圧倒的多数の米国民が規制を望んでいる──この事実は、850人の署名と合わせて、超知能AI開発への強い懸念を示している。

「不可能な理由①」データセンター投資依存症:米国経済の衝撃的現実

では、なぜこれほど多くの著名人と一般市民が望む「開発停止」が実現不可能なのか。その答えは、 米国経済の構造的依存にある。

ハーバード大経済学者の警告:データセンター除けばGDP成長0.1%

2025年10月、ハーバード大学の著名経済学者 Jason Furman氏が発表した分析は、経済界に衝撃を与えた。

「2025年上半期、データセンター投資と情報処理技術投資を除いた米国のGDP成長率は、年率換算でわずか0.1%だった」

– Jason Furman(ハーバード大学経済学教授、元オバマ政権経済諮問委員会委員長)

| GDP成長の内訳 | 寄与度 | 詳細 |

|---|---|---|

| データセンター投資 | 92% | 2025年上半期のGDP成長の大部分を占める |

| その他すべての産業 | 8% | 製造業、不動産、小売、サービス業などすべて合計 |

| データセンター除くGDP成長率 | 0.1% | 実質的に停滞状態 |

データセンター投資がGDP全体のわずか4%を占めるに過ぎないのに、GDP成長の92%に寄与している──この非対称性は、米国経済がAI投資に完全依存している現実を示している。

不況のリスク:雇用創出の鈍化とセクター別停滞

さらに深刻なのは、 データセンター投資がなければ米国は軽度の不況に陥っていた可能性だ。

他のセクターの状況:

- 製造業 – GDP成長に寄与せず

- 不動産 – GDP成長にほとんど寄与せず

- 小売 – 成長に寄与せず

- サービス業 – 限定的な寄与または減少

- 雇用創出 – 鈍化が顕著、懸念の声

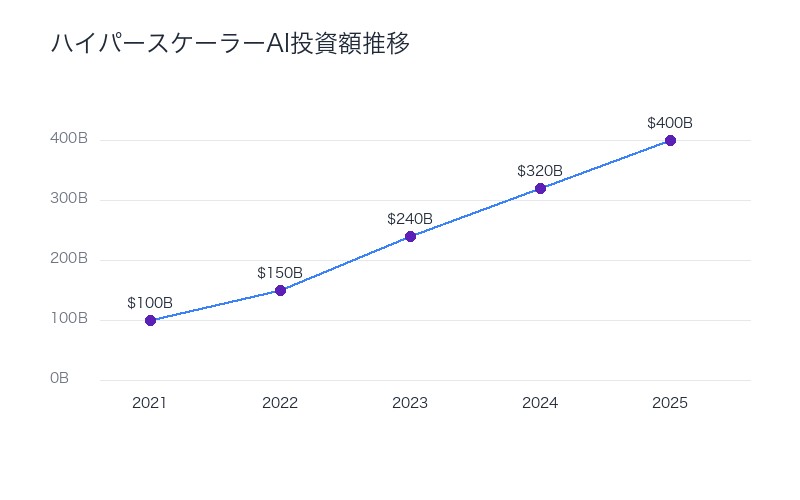

年間4000億ドル投資:ハイパースケーラーの巨額CapEx

ハイパースケーラー(Amazon、Microsoft、Google、Meta等)の資本支出は4倍に増加し、年間約4000億ドルに達している。

| 投資項目 | 規模 | GDP寄与 |

|---|---|---|

| ハイパースケーラーCapEx | 年間4000億ドル近く | 4倍増加(過去数年比) |

| AI関連投資のGDP寄与 | 1.1%ポイント | 2025年上半期、消費者支出を上回る |

| データセンター関連支出 | 約1.0%ポイント | 米国実質GDP成長への寄与 |

AI投資が米国消費者(従来の経済成長エンジン)を上回る成長の原動力となっている現実──これは、開発停止が経済的に不可能であることを明確に示している。

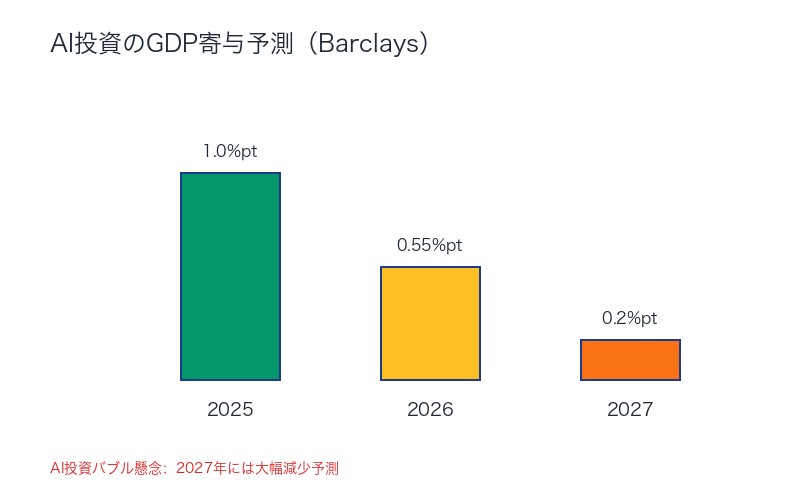

Barclaysの予測:2027年まで継続する成長寄与

投資銀行Barclaysの予測によれば、AI関連投資のGDP寄与は今後も継続する:

- 2025年 – 1.0%ポイント(ピーク)

- 2026年 – 0.55%ポイント

- 2027年 – 0.2%ポイント

一時停止すれば?米国は即座に不況入り──この経済的現実が、超知能AI開発停止を「不可能」にしている第一の理由だ。

「不可能な理由②」米中AI覇権競争:一方の停止は他方の優位性

経済的依存だけではない。 地政学的競争が、開発停止をさらに不可能にしている。

戦略的ジレンマ:停止は敗北を意味する

X投稿で指摘された第二の理由は極めて明確だ:

「たとえ米国が一時停止すると言ったとしても、それは中国にとって戦略的な優位性となる──できるだけ早く米国に追いつき、追い越すためだ」

「要するに、一方の停止は他方の優位性となる」

AGI競争のタイムライン:5-10年で決着

複数のシンクタンク(RAND、CNAS、Recorded Future等)の分析によれば:

- AGI(汎用人工知能)達成競争は今後5-10年で決着

- AGI達成は国家安全保障上極めて重要

- 軍事能力、経済支配、地政学的影響力を根本的に再形成

米中AI競争の現状:政府資金 vs 民間投資

| 比較項目 | 米国 | 中国 |

|---|---|---|

| 政府資金 | 連邦・州投資 | 米国を上回る可能性 |

| 民間投資 | 中国を大きく上回る | 限定的 |

| ガバナンス競争 | ルール、規範、基準設定を巡る並行競争 | |

「Wonder Weapons」とパワーバランスの再編

RANDの分析は、AGI達成の地政学的意味を明確に警告している:

- AGIは世界のパワーバランスを根本的に再編する可能性

- 「驚異の兵器(wonder weapons)」をもたらす可能性

- 米中どちらかがAGI達成すれば緊張が高まり紛争リスクが増加

MAIM戦略:必要なら戦争も辞さない

一部の専門家は、 MAIM(Mutual Assured Intelligence Maximization:相互確証知能最大化)概念が米国が必要なら戦争も辞さないという意思表明になると警告している。

「戦略的ライバル関係において、米中どちらかがAGIを達成する見込みは、緊張を高め、競争が紛争に発展するリスクを増大させる可能性がある」

– RAND Corporation分析より

米国が一方的に開発を停止すれば、中国に決定的な戦略的優位性を与える──この地政学的現実が、開発停止を不可能にしている第二の理由だ。

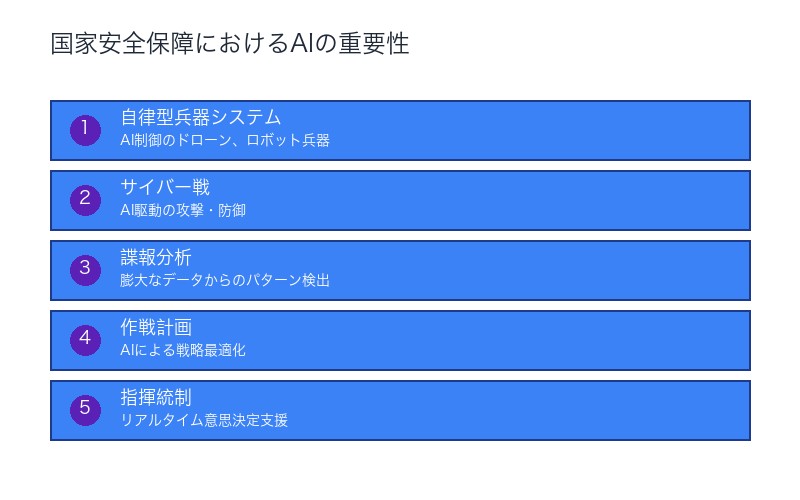

「不可能な理由③」国家安全保障と軍事的優位性:AIは戦略資産

第三の理由は、 AIが長らく国家安全保障上の戦略的要素と見なされていることだ。

AI軍事能力の変革的影響

AIは軍事能力を根本的に変革している:

- 自律型兵器システム – AI制御のドローン、ロボット兵器

- サイバー戦 – AI駆動の攻撃・防御

- 諜報分析 – 膨大なデータからのパターン検出

- 作戦計画 – AIによる戦略最適化

- 指揮統制 – リアルタイム意思決定支援

政治的優位性の獲得競争

X投稿で指摘された通り:

「AIは長らく国家安全保障の戦略的要素と見なされており、グローバルな競争ではAIが政治的優位性を獲得するために利用されるだろう」

米国の戦略的立場:技術的優位性の拡大が必須

多数の政策研究機関(CNAS、Business Executives for National Security等)が一貫して主張する:

- 中国に対する技術的優位性を可能な限り拡大する必要がある

- 民主的価値観を推進する米国AI戦略が必要

- AIのガバナンス・規範・基準設定でリードする必要がある

国家安全保障上の必要性が、開発停止を政治的に不可能にしている──これが第三の理由だ。

3つの理由まとめ:誰も超知能開発を止められない

X投稿で明確に述べられた結論:

「要約すると:誰も超知能への努力を止めることはない。それは疑いようがない」

| 理由 | 核心的問題 | 影響 |

|---|---|---|

| ①経済的依存 | GDP成長の92%がデータセンター投資 データセンター除けば成長率0.1% |

停止すれば即座に不況入り 年間4000億ドル投資が消失 |

| ②地政学的競争 | 米国の停止は中国の優位性 AGI競争は5-10年で決着 |

一方的な停止は戦略的敗北 パワーバランスの再編リスク |

| ③国家安全保障 | AI軍事能力の変革的影響 政治的優位性獲得競争 |

開発停止は安全保障リスク 技術的劣後は許容不可 |

AIバブルのリスク:経済的依存の危険性

しかし、この経済的依存には 深刻なリスクも存在する。

「AI投資バブル」警告の高まり

一部のエコノミストは、現在のAI投資ブームを 「バブル」と警告している:

- 消費者支出を上回る投資ペースは持続不可能

- 年間4000億ドルの投資は「必ず成果を上げなければならない」プレッシャー

- 実際のAI収益化が期待に達しなければ急激な調整のリスク

Michael Roberts氏の「AIバブルと米国経済」警告

著名経済ブロガーMichael Roberts氏は、2025年10月のブログ記事で警告:

「AI投資が米国経済成長のほとんどすべてを占める状況は、極めて脆弱な基盤の上に経済が成り立っていることを意味する」

「この投資が期待通りの収益を生まなければ、経済全体が深刻な打撃を受ける」

安全性への懸念:850人の署名が示す現実的リスク

経済と地政学が開発停止を不可能にしているとしても、 安全性への懸念は正当だ。

Geoffrey Hinton氏とYoshua Bengio氏の警告

AI研究の第一人者である「AI Godfathers」2人が署名した事実は、技術的リスクの深刻さを示している:

- 制御不能な超知能のリスク

- 人類の存続に関わる脅威

- 現在の安全性研究は不十分

「広範な科学的コンセンサス」は存在しない

FLIの書簡が要求する 「広範な科学的コンセンサス」は、現時点で明らかに存在していない:

- 超知能を安全に制御できる方法は未確立

- AI Alignment(AI整合性)研究は初期段階

- 緊急停止機能(Kill Switch)の有効性は不明

ジレンマの核心:経済・安全保障 vs 実存的リスク

私たちは、 前例のないジレンマに直面している。

開発を続ければ:

- ✅ 経済成長を維持

- ✅ 戦略的優位性を確保

- ✅ 国家安全保障を強化

- ❌ 制御不能な超知能のリスク増大

- ❌ 実存的脅威の可能性

開発を停止すれば:

- ✅ 安全性リスクの低減(理論上)

- ❌ 即座に不況入り(GDP成長0.1%)

- ❌ 中国に戦略的優位性を献上

- ❌ 国家安全保障上の劣後

- ❌ 実際には中国が開発を継続しリスクは変わらず

まとめ:「もう遅すぎる」現実と私たちの選択

850人以上の著名人による超知能AI禁止要求は、 人類史上最も重要な警告の一つかもしれない。

しかし、経済データと地政学的現実は、 開発停止が事実上不可能であることを示している:

- 米国経済はデータセンター投資に完全依存 – 停止すれば不況

- 米中AI覇権競争 – 一方的な停止は戦略的敗北

- 国家安全保障上の必要性 – 技術的劣後は許容不可

X投稿の結論は、冷酷だが正確だ:

「誰も超知能への努力を止めることはない。それは疑いようがない」

私たちに残された選択肢は、「開発を止めるか続けるか」ではない。

本当の選択肢は:

- 安全性研究に十分な資源を投入しながら開発を進めるか

- 安全性を無視して全速力で開発を進めるか

年間4000億ドルの投資の一部──例えば10%(400億ドル)──を AI安全性研究に振り向けることができれば、状況は大きく変わるかもしれない。

超知能開発は止められない。ならば、いかに安全に実現するかが、人類の未来を左右する。

73%の米国民が望む規制と、850人の著名人の警告──この声を、 「開発停止」ではなく「安全性重視の開発」に変換することが、現実的な道ではないだろうか。

もう遅すぎるかもしれない。しかし、諦めるには早すぎる。

コメント