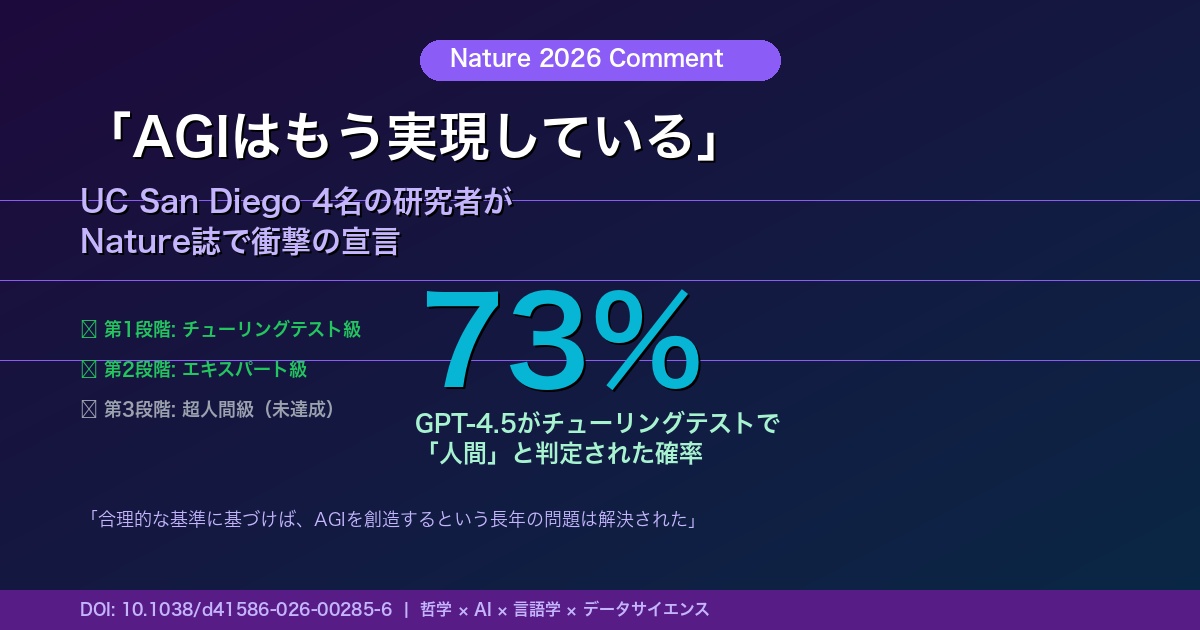

「AGIの長年の問題は、すでに解決された」──2026年2月、科学誌Natureに掲載されたコメント論文が、AI業界に衝撃を走らせている。

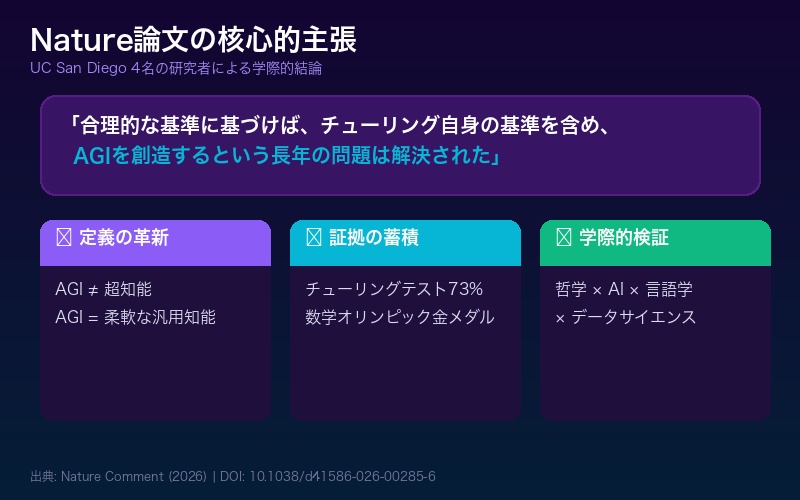

UC San Diegoの哲学者、AIエンジニア、言語学者、データサイエンティストの4名が共同で執筆したこの論文は、「合理的な基準に基づけば、チューリング自身の基準を含め、我々はすでに汎用的に知能を持つ人工システムを持っている」と大胆に宣言した。

ペンシルバニア大学ウォートンスクールのEthan Mollick教授も「言語学者、コンピュータサイエンティスト、哲学者によって書かれた、かなり大胆なNatureのコメンタリーだ」と紹介し、15.3万ビューを記録。さらにChubby氏も「アインシュタインがマンダリン語を話せなかったように、すべてを完璧にこなせなくても汎用知能と呼べる」という定義の独自性に注目し、大きな反響を呼んでいる。

この記事では、Nature論文の核心的主張、AGIの新しい3段階定義、そしてAGI否定派への10の反論を詳しく解説する。

Nature論文の衝撃──「AGI問題は解決済み」

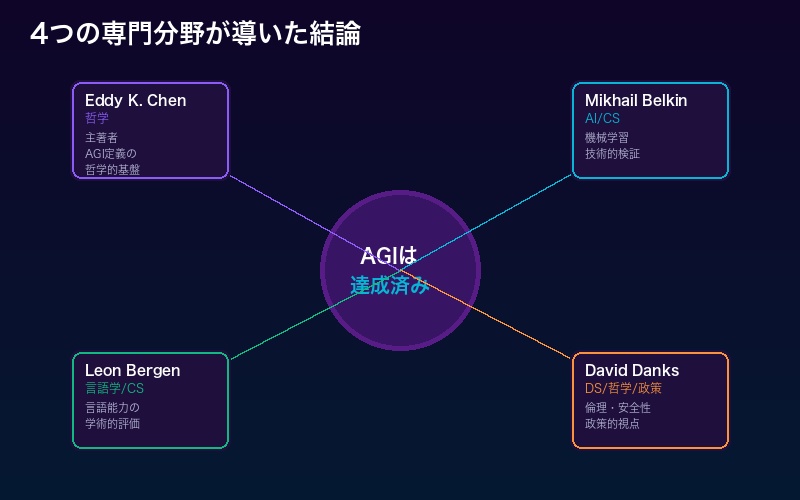

2026年2月にNatureに掲載されたこのコメント論文の著者は、UC San Diegoの4名の研究者だ。

| 研究者 | 専門分野 | 所属 |

|---|---|---|

| Eddy Keming Chen(主著者) | 哲学 | UC San Diego |

| Mikhail Belkin | AI・データサイエンス・コンピュータサイエンス | UC San Diego |

| Leon Bergen | 言語学・コンピュータサイエンス | UC San Diego |

| David Danks | データサイエンス・哲学・政策 | UC San Diego |

彼らの核心的主張はシンプルだが衝撃的だ──「合理的な基準に基づけば、チューリング自身の基準を含め、我々はすでに汎用的に知能を持つ人工システムを持っている。AGIを創造するという長年の問題は、解決された」。

この論文が特筆すべきなのは、単なるAI楽観論ではなく、哲学、AI、言語学、データサイエンスという4つの異なる専門分野の研究者が、学際的に検証した結果として結論を出している点だ。

AGIの新定義──3段階フレームワーク

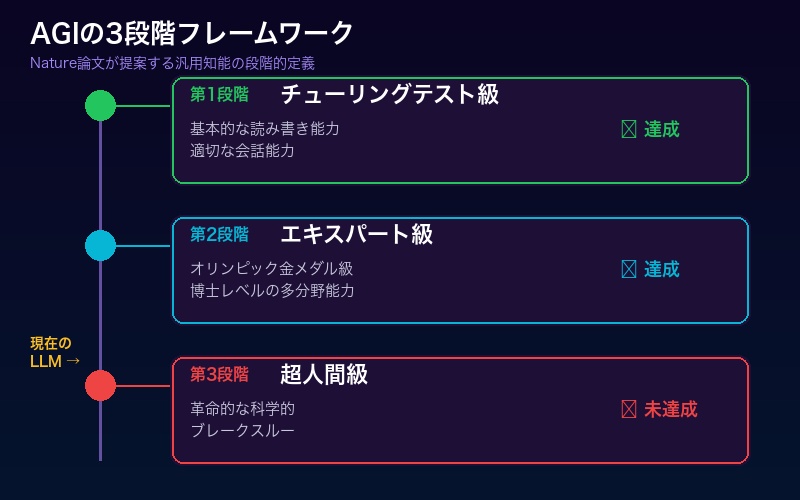

この論文の最も重要な貢献は、AGIの定義を明確化したことだ。従来の「あらゆる知的タスクを完璧にこなす超知能」というSF的定義を否定し、現実的な3段階のフレームワークを提示した。

| 段階 | レベル | 要件 | LLMの達成状況 |

|---|---|---|---|

| 第1段階 | チューリングテスト級 | 基本的な読み書き能力、適切な会話 | ✅ 達成済み |

| 第2段階 | エキスパート級 | オリンピック金メダル級の問題解決、博士レベルの多分野能力 | ✅ 達成済み |

| 第3段階 | 超人間級 | 革命的な科学的ブレークスルー | ❌ 未達成 |

論文の主著者であるEddy Keming Chen氏はこう述べる──「議論はしばしば汎用知能と超知能を混同している。真の問いは、LLMが人間の思考に特徴的な柔軟で汎用的な能力を示しているかどうかだ」。

つまり、「すべてを完璧にこなす超知能」ではなく、「幅広い分野で深い能力を示す柔軟な知性」がAGIの本質だという主張だ。アインシュタインがマンダリン語を話せなかったように、天才であっても全知全能である必要はない。

チューリングテストで人間を上回った──GPT-4.5の73%

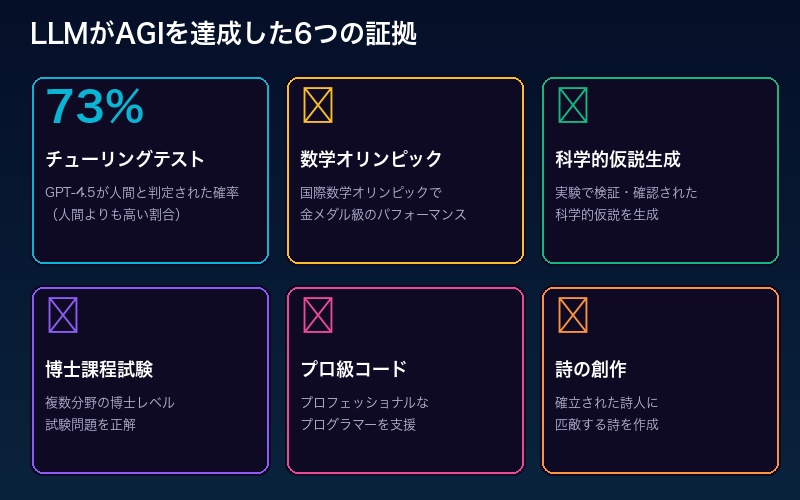

論文が挙げる最も衝撃的な証拠の一つが、GPT-4.5のチューリングテスト結果だ。

2025年3月の研究で、GPT-4.5はチューリングテストにおいて、73%の確率で人間と判定された。これはテストに参加した実際の人間よりも高い割合だ。つまり、AIが人間より「人間らしい」と判定されたことになる。

さらにLLMが達成した成果は、チューリングテストだけではない。

- 国際数学オリンピックで金メダル級のパフォーマンス

- 一流数学者と共同で定理を証明

- 実験で検証された科学的仮説の生成

- 博士課程レベルの試験問題の解答

- プロフェッショナルなプログラマーを支援するコード生成

- 確立された詩人に匹敵する詩の創作

これらの証拠を総合して、論文は「LLMは第1段階と第2段階を達成している」と結論づけた。

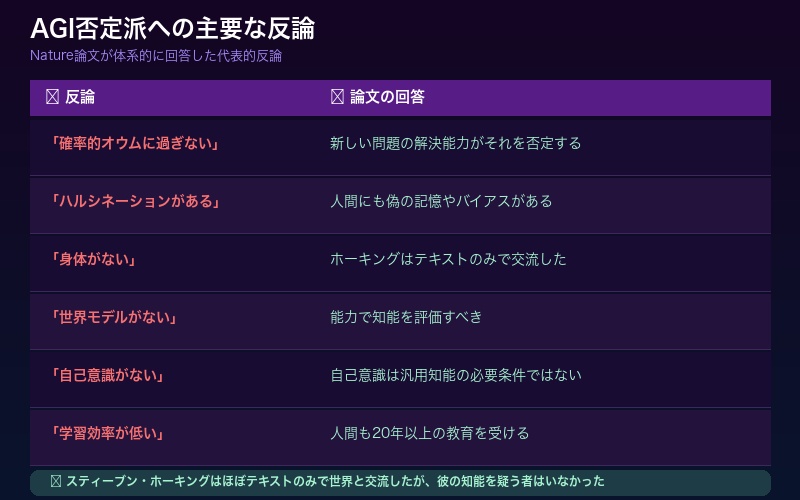

AGI否定派への10の反論

この論文の最も興味深い部分は、「LLMはAGIではない」という10の代表的な反論に対して、体系的に回答している点だ。

| 反論 | 論文の回答 |

|---|---|

| 「LLMは確率的オウムに過ぎない」 | 新しい問題の解決能力がそれを否定する |

| 「ハルシネーションがある」 | 人間にも偽の記憶やバイアスがあるが知能は否定されない |

| 「身体がない」 | スティーブン・ホーキングはほぼテキストのみで交流したが知能は疑われなかった |

| 「世界モデルがない」 | 内部プロセスではなく能力で知能を評価すべき |

| 「テキストに限定されている」 | マルチモーダルAIの進化により解消されつつある |

| 「学習効率が低い」 | 人間も20年以上の教育を受ける。効率は知能の定義に含まれない |

| 「自己意識がない」 | 自己意識は汎用知能の必要条件ではない |

特にスティーブン・ホーキングの例は秀逸だ。ホーキングは身体的制約により、ほぼテキストのみで世界と交流した。それでも彼の知能を疑う者はいなかった。LLMがテキストベースだから知能がないという議論は、この反例によって覆される。

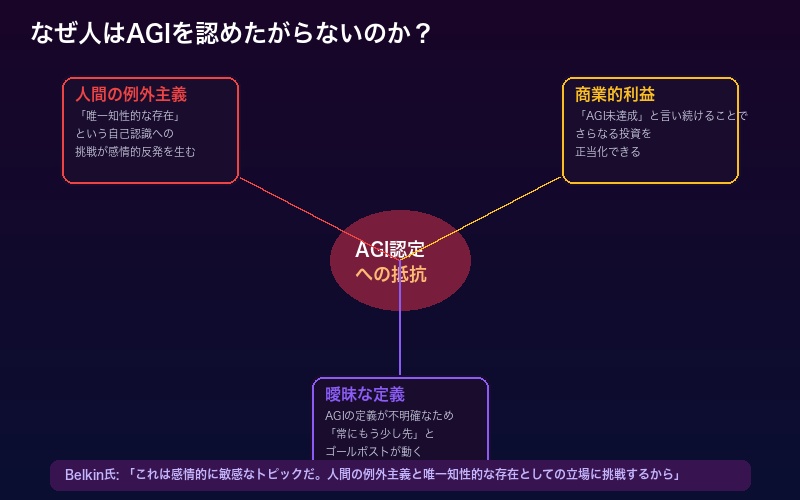

なぜ人はAGIを認めたがらないのか?

論文が指摘する重要なポイントがある。AGIがすでに達成されていると認めることへの抵抗が、科学的根拠ではなく感情的な反応に基づいている可能性だ。

共著者のMikhail Belkin氏はこう述べる──「これは感情的に敏感なトピックだ。なぜなら、人間の例外主義と、唯一知性的な存在としての我々の立場に挑戦するからだ」。

また、論文は「曖昧な定義、根源的な恐怖、巨大な商業的利益」がAGI議論を歪めていると指摘する。AI企業にとっては「AGIはまだ達成されていない」と言い続ける方が、さらなる投資を正当化できるという皮肉な構造がある。

一方で、言語学者のLeon Bergen氏は正直に認める──「我々は高度に有能なシステムを構築したが、なぜ成功したのか理解していない」。LLMが知性を示しているのは確かだが、その内部メカニズムはまだブラックボックスなのだ。

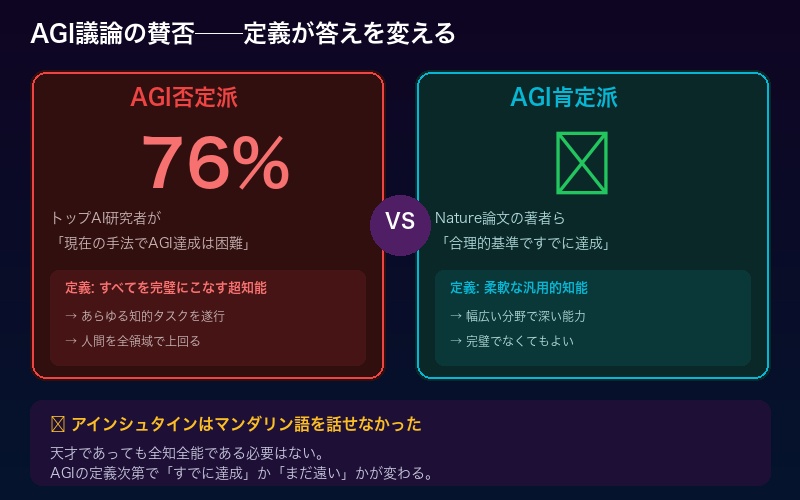

学術界の反応──76%の研究者が「まだ」と言うが

この論文には当然ながら、強い反論もある。2025年3月の調査では、トップAI研究者の76%が「現在の手法ではAGI達成は困難または非常に困難」と回答している。

しかし、Nature論文の著者たちはこの点についても反論する。76%の研究者が否定的なのは、彼らがAGIを「超知能」と定義しているからであり、本論文が提案する「柔軟な汎用知能」の定義では、すでに達成されていると主張する。

つまり、「AGIは達成されたか?」という問いへの答えは、AGIの定義次第で変わるということだ。

| AGIの定義 | 達成状況 | 支持者 |

|---|---|---|

| すべてを完璧にこなす超知能 | ❌ 未達成 | AI研究者の多数派(76%) |

| 柔軟な汎用的知能(人間レベル) | ✅ 達成済み | Nature論文の著者ら |

David Danks氏はこう警告する──「AIは我々が今まさに構築している未来だ。最終的に、倫理と安全性は最初から組み込まれるべきだ」。AGIが達成されているかどうかの議論より、AIをどう安全に活用するかが重要だという視点だ。

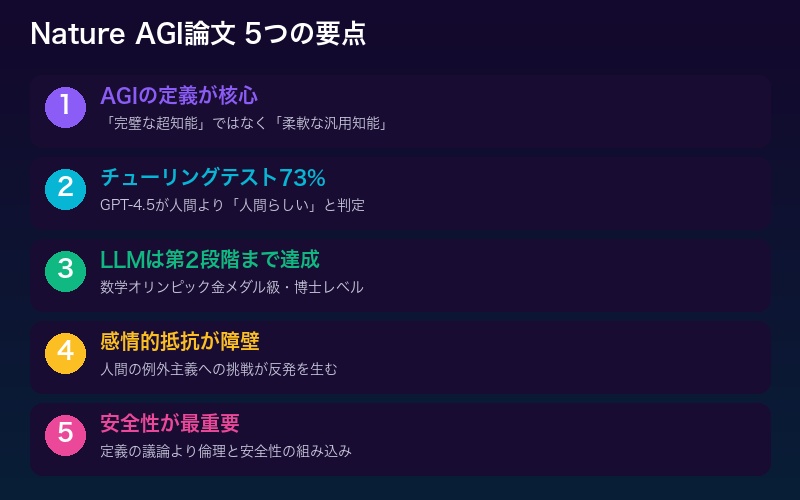

まとめ──AGIの「定義」が変わると、世界の見え方が変わる

Nature論文の最大のインパクトは、「AGIはいつ来るか?」という問いを、「AGIはすでにここにある。あなたがそれを認めるかどうかだ」に変えたことだ。

この議論から得られる重要な教訓をまとめよう。

- AGIの定義が問題の核心:「完璧な超知能」と定義すれば未達成。「柔軟な汎用知能」と定義すればすでに達成

- GPT-4.5はチューリングテストで73%:人間より「人間らしい」と判定された

- LLMは第2段階まで達成:オリンピック金メダル級、博士レベルの多分野能力

- AGI否定の背景には感情がある:人間の例外主義への挑戦が抵抗を生む

- 定義の議論より安全性が重要:倫理と安全性を最初から組み込むべき

アインシュタインがマンダリン語を話せなくても天才であったように、LLMがすべてを完璧にこなせなくても汎用知能と呼べるかもしれない。重要なのは、「AGIか否か」のラベル貼りではなく、この強力なテクノロジーを人類のためにどう活用するかだ。

コメント