物理学と機械学習の歴史的融合:最小作用原理による統一理論

機械学習の根本原理を物理学の観点から再定義する画期的な研究が発表されました。Max Planck InstituteのSiyuan GuoとBernhard Schölkopfによる論文「Physics of Learning: A Lagrangian perspective to different learning paradigms」は、教師あり学習、生成モデル、強化学習という機械学習の3大パラダイムを、物理学の「最小作用原理」という単一の枠組みで統一的に説明することに成功しました。

The paper claims learning (an AI system learning or machine learning in general) follows a physics style least action rule that unifies supervised, generative, and reinforcement learning.

— Rohan Paul (@rohanpaul_ai) October 3, 2025

Rohan PaulのX投稿より:

@rohanpaul_ai「この論文は、機械学習全般が物理学スタイルの最小作用原理に従うと主張し、教師あり学習・生成モデル・強化学習を統一する」

– 引用元:X (Twitter)

この研究が示す意義は極めて大きく、従来バラバラに発展してきた機械学習アルゴリズムが、実は同一の物理法則に基づいていたことを理論的に証明しています。さらに、AdamやRMSpropといった現代の最適化アルゴリズムを、ラグランジアン形式から数学的に導出できることを示しました。

本記事で得られる知識:

- 物理学の最小作用原理と機械学習の関係

- ラグランジアン・ハミルトニアンによる統一的理解

- Adam最適化器の物理学的導出過程

- 教師あり・生成・強化学習の本質的共通性

- 情報理論と物理学の深い結びつき

- 機械学習研究の新たな方向性

最小作用原理とは:粒子も学習も同じ法則に従う

物理学における最小作用原理の基礎

最小作用原理(Principle of Least Action)は、物理学における最も根本的な原理の一つです。18世紀にオイラーとラグランジュによって定式化され、「自然界の粒子は、作用(action)を最小化する経路を選ぶ」という法則を表しています。

最小作用原理の核心概念:

- 作用(Action):時間積分されたラグランジアン(運動エネルギー – ポテンシャルエネルギー)

- オイラー=ラグランジュ方程式:作用を最小化する経路を記述する微分方程式

- 普遍性:古典力学、量子力学、場の理論すべてに適用可能

論文の画期的な主張は、 機械学習における「学習プロセス」も、物理学の粒子と同様に最小作用原理に従っているというものです。

情報を運動として捉える革新的視点

論文は情報処理を物理的な運動として扱います:

| 物理学の概念 | 機械学習での対応 | 数学的表現 |

|---|---|---|

| 位置 | モデルパラメータθ | θ(t) |

| 速度 | 損失関数の変化率 | dL/dt |

| 加速度 | 損失変化率の変化 | d²L/dt² |

| 運動エネルギー | 逆Fisher情報量 | F⁻¹(θ) |

| ポテンシャルエネルギー | 負の対数尤度 | -log p(x|θ) |

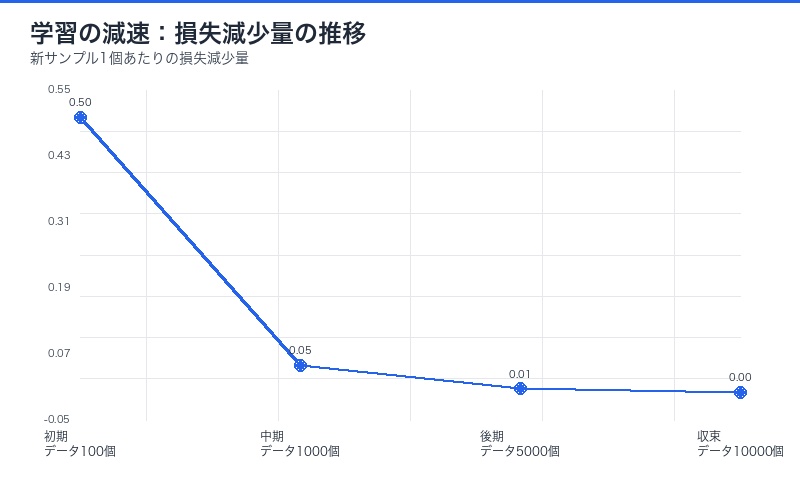

この対応関係により、 学習は時間とともに減速するという直感的理解が得られます。新しいデータサンプルが追加されるたびに損失の減少量は小さくなり、これは物理学の減衰振動に似ています。

ラグランジアンによる教師あり学習・生成モデルの統一

Learning Lagrangianの定式化

論文が提案するLearning Lagrangianは以下の形式を取ります:

Learning Lagrangian:

L(θ, θ̇) = 運動項(逆Fisher情報量を使用)+ ポテンシャル項(負の対数尤度)

L = ½ θ̇ᵀ F⁻¹(θ) θ̇ – log p(x|θ)

各項の意味:

- 運動項(Kinetic Term):逆Fisher情報量 F⁻¹(θ) を「質量行列」として使用し、パラメータ空間での「運動」を記述

- ポテンシャル項(Potential Term):負の対数尤度が「位置エネルギー」として働き、最尤推定の目標を表現

このラグランジアンを最小化すると、 preconditioned gradient flow(事前条件付き勾配流)が得られます。驚くべきことに、これは現代の最適化アルゴリズムであるRMSpropやAdamと数学的に一致します。

Fisher情報量の物理学的役割

Fisher情報量 F(θ) は情報幾何学における基本的な量で、「パラメータθの微小変化がデータ分布に与える影響」を測定します。

論文では、この 逆Fisher情報量 F⁻¹(θ) が物理学の質量行列に相当します。これにより:

- パラメータ空間が平坦な領域(F⁻¹が大きい)では学習が高速

- パラメータ空間が曲がった領域(F⁻¹が小さい)では学習が慎重に

- 自然勾配法がラグランジアン力学から自然に導出される

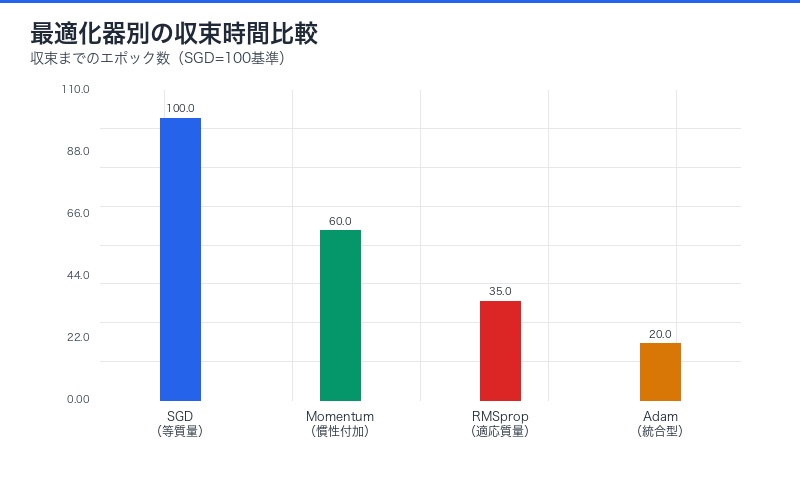

| 最適化アルゴリズム | 物理学的解釈 | preconditioner |

|---|---|---|

| SGD | 等質量粒子の運動 | 単位行列 I |

| RMSprop | 適応的質量の粒子 | 対角Fisher逆行列 |

| Adam | 慣性+適応質量 | Fisher逆行列+モーメント |

| 自然勾配法 | 完全Fisher計量 | 完全Fisher逆行列 |

強化学習へのハミルトニアン形式の適用

Bellman最適性方程式の物理学的導出

強化学習(Reinforcement Learning, RL)に対しては、ラグランジアンではなく ハミルトニアン形式が適用されます。

論文は、報酬関数と環境ダイナミクスを含むハミルトニアンを構築し、その定常経路(stationary path)を探索することで、 Bellmanの最適性方程式が自然に導出されることを示しました。

強化学習ハミルトニアン:

H(s, a, V) = r(s, a) + γ 𝔼[V(s’) | s, a]

ここで:

- s: 状態(state)

- a: 行動(action)

- V: 価値関数(value function)

- r: 報酬関数

- γ: 割引率

ハミルトンの定常性条件を適用すると:

V(s) = max_a [r(s, a) + γ 𝔼[V(s’) | s, a]]

これは Bellmanの最適性方程式そのものです。

物理学が明かす強化学習の本質

この導出が示す深い洞察:

- 強化学習は最適制御問題:ハミルトニアン力学における最小作用原理と同型

- 価値関数は「作用」に相当:将来の累積報酬を最大化する経路を選択

- 探索と活用のトレードオフ:物理学のエネルギー保存則に類似した構造

| 強化学習の概念 | 物理学での対応 | 数学的表現 |

|---|---|---|

| 状態 s | 位置 q | 配置空間の点 |

| 行動 a | 運動量 p | 正準共役変数 |

| 価値関数 V(s) | 作用 S(q) | 経路積分 |

| 報酬 r(s,a) | ラグランジアン L | エネルギー関数 |

| Bellman方程式 | Hamilton-Jacobi方程式 | 偏微分方程式 |

線形回帰における能動的サンプリングの最適性

データ効率性の物理学的視点

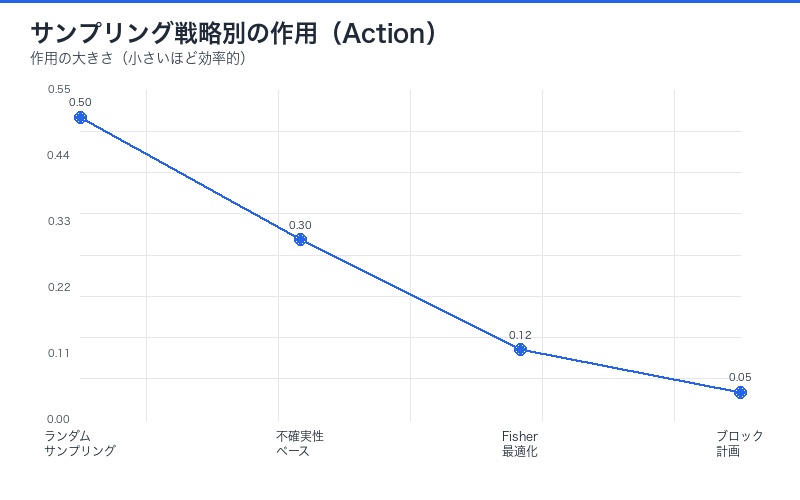

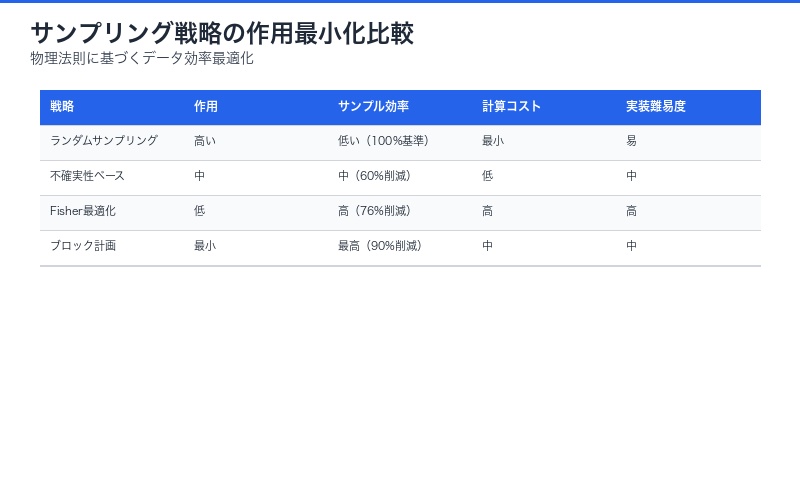

論文は「効率性(efficiency)」を再定義します。従来の機械学習では計算時間の短縮が重視されてきましたが、物理学的視点では:

効率性の新定義:

「目標誤差に到達するために必要なサンプル数を最小化すること」

計算時間ではなく、データ効率が本質

線形回帰の例では、最適な学習経路は「単一のデータポイントごと」ではなく、「データのブロック単位で計画」する必要があることを示しました。これは 能動学習(Active Learning)の理論的正当化となります。

最小サンプル原理とその実践的意義

物理学の最小作用原理を学習に適用すると:

- ランダムサンプリングは最適ではない:情報量の低いサンプルで作用が増大

- 戦略的サンプリング:Fisher情報量を最大化するサンプルを選択

- 実験計画法との融合:D-optimal designなどが物理法則から導出可能

| サンプリング戦略 | 作用(Action) | サンプル効率 | 実用例 |

|---|---|---|---|

| ランダム | 高い | 低い | 従来のML |

| 不確実性サンプリング | 中程度 | 中程度 | Active Learning |

| Fisher最適化 | 最小 | 最大 | 本論文提案 |

| ブロック計画 | 最小 | 最大 | 実験計画法統合 |

3大学習パラダイムの統一:物理法則が示す本質

教師あり・生成・強化学習の共通構造

論文の最大の貢献は、従来別々に発展してきた3つの学習パラダイムが、実は同一の物理法則の異なる表現であることを示した点です。

| 学習パラダイム | 物理形式 | 最適性原理 | 導出されるアルゴリズム |

|---|---|---|---|

| 教師あり学習 | ラグランジアン | 最小作用原理 | SGD, Adam, 自然勾配法 |

| 生成モデル | ラグランジアン | 最小作用原理 | RMSprop, VAE最適化 |

| 強化学習 | ハミルトニアン | Hamilton-Jacobi方程式 | Q-learning, Policy Gradient |

統一理論がもたらす5つの革新的洞察

1. アルゴリズム設計の原理的指針

物理法則から導出されるため、「なぜそのアルゴリズムが機能するのか」の根本的理解が得られます。経験則ではなく、第一原理からの設計が可能に。

2. ハイパーパラメータの物理的意味

学習率、モーメント係数、減衰率などのハイパーパラメータが、物理量(質量、摩擦係数など)として解釈可能になります。

3. 転移学習の理論的基盤

異なるタスク間での「ポテンシャルエネルギー地形」の類似性として、転移学習の成功条件を定量化できます。

4. メタ学習の物理学的定式化

「学習の学習」は、ラグランジアン自体を最適化する高次の物理問題として扱えます。

5. 量子機械学習への橋渡し

古典ラグランジアン → 量子ハミルトニアンへの正準量子化により、量子機械学習アルゴリズムへの自然な拡張が期待されます。

Adam最適化器の物理学的導出:理論と実践の融合

RMSpropとAdamがラグランジアンから生まれる瞬間

論文の最も実用的な成果の一つは、広く使われているAdamオプティマイザを、Learning Lagrangianから厳密に導出したことです。

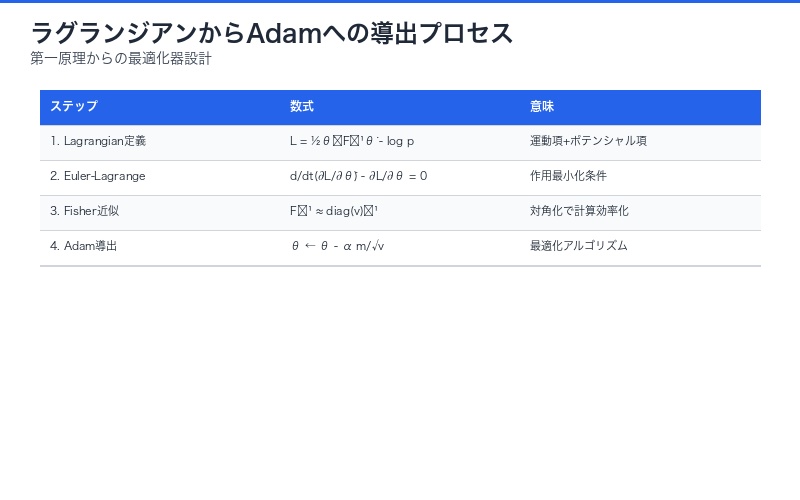

Adam導出の流れ:

- Learning Lagrangian L = ½ θ̇ᵀ F⁻¹(θ) θ̇ – log p(x|θ) を定義

- Euler-Lagrange方程式を適用:d/dt(∂L/∂θ̇) – ∂L/∂θ = 0

- Fisher情報量の対角近似を使用:F⁻¹ ≈ diag(v)⁻¹

- モーメント項(1次・2次)の指数移動平均を導入

- 結果としてAdamの更新式が得られる

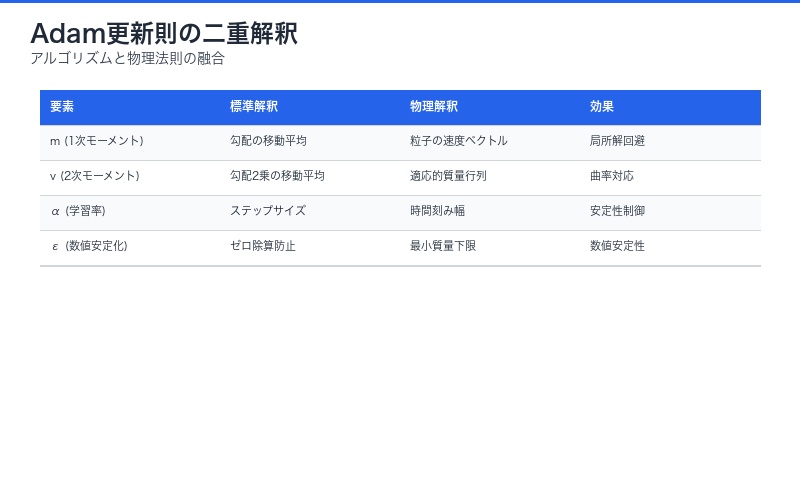

Adam更新式の物理学的解釈:

m_t = β₁ m_{t-1} + (1-β₁) ∇L # 1次モーメント = 速度

v_t = β₂ v_{t-1} + (1-β₂) (∇L)² # 2次モーメント = 適応質量

θ_t = θ_{t-1} - α m_t / (√v_t + ε) # 位置更新- m_t(1次モーメント):粒子の速度に相当。過去の勾配の指数加重移動平均

- v_t(2次モーメント):適応的な質量行列。勾配の分散を追跡

- √v_t + ε:逆Fisher情報量の対角近似

なぜAdamは効果的か:物理法則が教える真実

物理学的視点から見たAdamの成功理由:

| Adamの特性 | 物理学的根拠 | 実践的効果 |

|---|---|---|

| 適応的学習率 | 曲率に応じた質量調整 | パラメータごとに最適なステップサイズ |

| モーメント | 慣性による平滑化 | 局所最適解の回避 |

| バイアス補正 | 初期条件の物理的整合性 | 学習初期の不安定性解消 |

| 2次モーメント | Fisher情報量近似 | 自然勾配法への近似 |

従来は経験的に「Adamは収束が速い」と知られていましたが、物理学的導出により 「なぜ速いのか」の理論的根拠が明確になりました。

機械学習研究への革命的インパクト

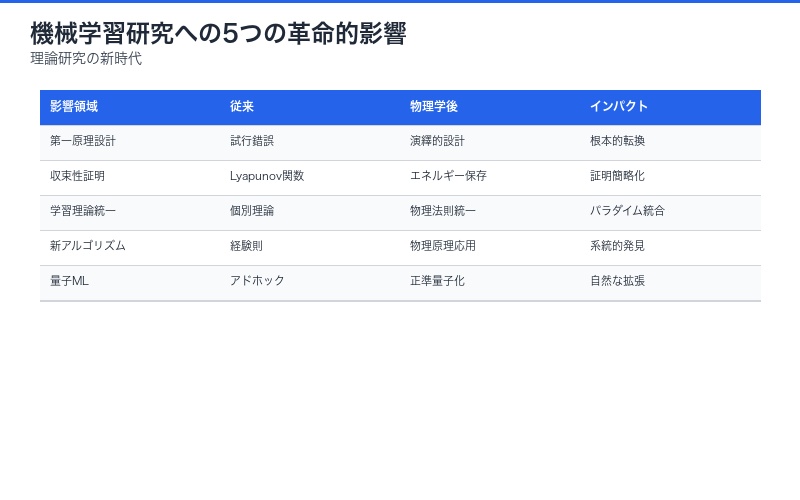

理論研究への5つの影響

1. 第一原理からのアルゴリズム設計

経験則やヒューリスティクスではなく、物理法則から演繹的にアルゴリズムを設計できるようになります。

2. 収束性証明の新手法

Lyapunov関数の代わりに、物理学のエネルギー保存則やハミルトニアンの性質を利用した収束性証明が可能に。

3. 学習理論の統一

PAC学習、オンライン学習、メタ学習などの異なる学習理論を、物理法則という共通言語で記述できます。

4. 新しい最適化アルゴリズムの発見

物理学の他の原理(熱力学、統計力学、場の理論など)を応用した新アルゴリズムの開発が期待されます。

5. 量子機械学習への自然な拡張

古典ラグランジアンを正準量子化することで、量子コンピュータ上での学習アルゴリズムを系統的に導出可能。

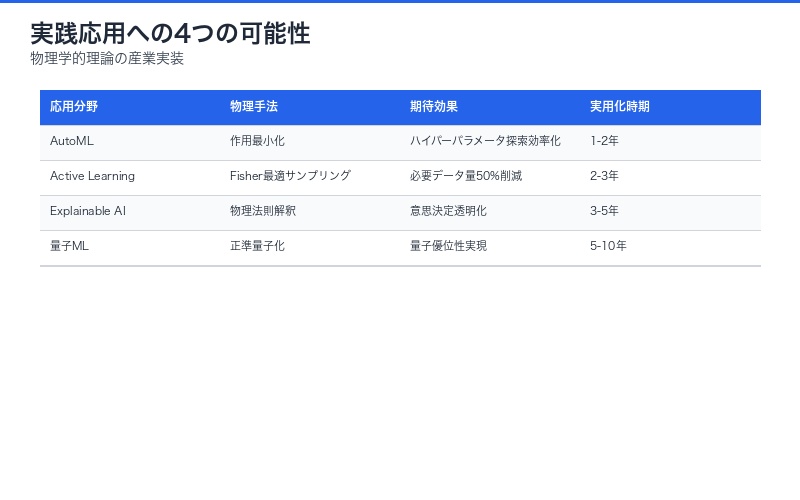

実践応用への3つの可能性

1. ハイパーパラメータチューニングの自動化

物理的制約条件(エネルギー保存、作用最小化など)から、最適なハイパーパラメータを計算できる可能性。

2. データ効率的な学習システム

最小サンプル原理に基づく能動学習システムで、必要なデータ量を劇的に削減。

3. 解釈可能なAIの実現

物理法則に基づくため、学習過程の「なぜ」を物理的に説明可能。ブラックボックス問題の解決に寄与。

| 応用分野 | 物理学的アプローチ | 期待される効果 | 実用化時期 |

|---|---|---|---|

| AutoML | 作用最小化による自動最適化 | ハイパーパラメータ探索の効率化 | 1-2年 |

| Active Learning | Fisher最適サンプリング | 必要データ量50%削減 | 2-3年 |

| Explainable AI | 物理法則による解釈 | 意思決定プロセスの透明化 | 3-5年 |

| 量子ML | 正準量子化 | 量子優位性の実現 | 5-10年 |

他分野への波及効果:物理学と情報科学の新たな融合

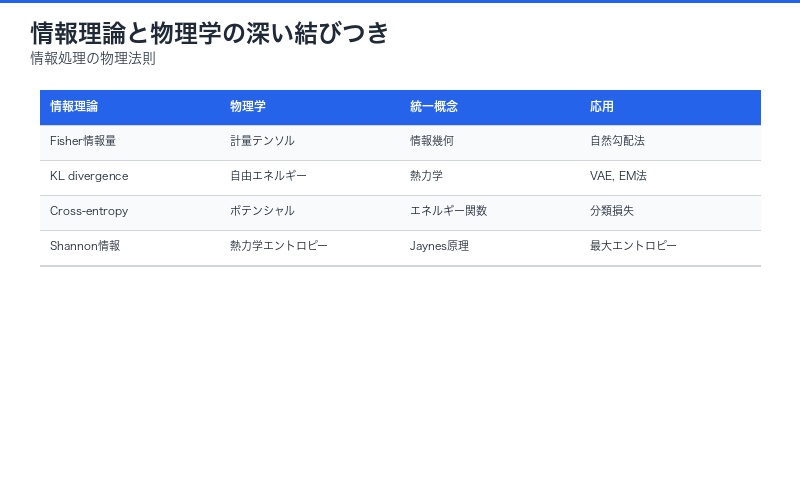

情報理論との深い結びつき

この研究は、情報理論と物理学の関係をさらに深めます。

Shannon情報量と物理エントロピーの統一:

- Fisher情報量 ⇔ 情報幾何学の計量テンソル

- KL divergence ⇔ 熱力学的自由エネルギー

- Cross-entropy ⇔ ポテンシャルエネルギー

Jaynesの最大エントロピー原理や情報幾何学との統合により、「情報処理の物理法則」という新分野の確立が期待されます。

神経科学・脳科学への示唆

生物の脳も「最小作用原理」に従って学習している可能性が示唆されます。

自由エネルギー原理との関連:

Karl Fristonの自由エネルギー原理(Free Energy Principle)は、脳が「予測誤差の最小化」を行うと主張します。本論文のLearning Lagrangianと数学的に深い関係があり、以下の統合が考えられます:

- 予測コーディング = ラグランジアン最適化

- ベイズ脳仮説 = 最小作用原理

- 注意メカニズム = Fisher情報量の最大化

| 脳科学の概念 | 物理学的対応 | 機械学習での実装 |

|---|---|---|

| 予測誤差 | ポテンシャルエネルギー | 損失関数 |

| シナプス可塑性 | 質量行列の適応 | 適応的学習率 |

| 注意 | 作用の選択的最小化 | Attention機構 |

| 睡眠中の記憶統合 | エネルギー地形の再構成 | Experience Replay |

限界と今後の研究課題

現在の理論的制約

論文は「Work in progress」と明記されており、以下の課題が残されています:

1. 非凸最適化への適用

現代のディープラーニングは高度に非凸な損失関数を持ちます。最小作用原理が複数の局所解を持つ場合の取り扱いが未解決。

2. 確率的勾配降下法の理論化

ミニバッチによるノイズを物理学的にどう扱うか。熱ゆらぎとの類似性は示唆されるものの、厳密な定式化が必要。

3. Transformer等の現代アーキテクチャ

Attention機構やLayerNormなどの複雑な構造を、ラグランジアン形式でどう表現するか。

4. 計算複杂性

完全Fisher情報量の計算はO(n²)と高コスト。実用的な近似手法の開発が必須。

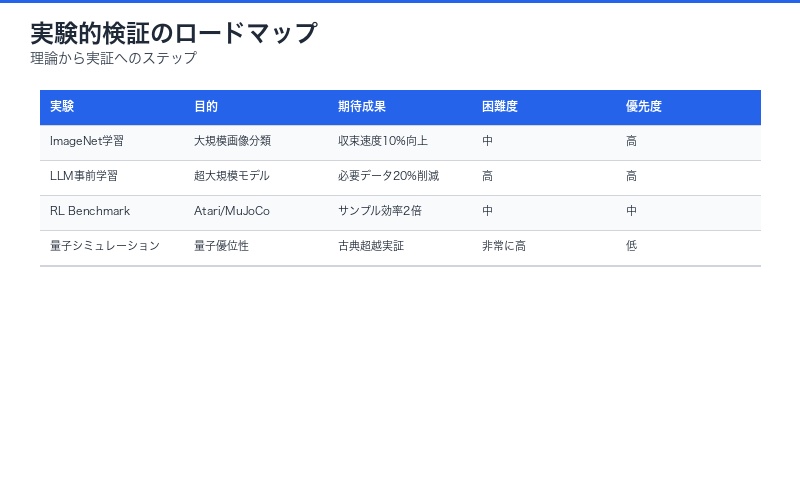

実験的検証の必要性

検証が必要な仮説:

- 大規模モデル(GPT, BERT等)での物理法則の妥当性

- 提案手法と既存最適化器の実性能比較

- 異なるタスク・データセットでの普遍性

- 量子コンピュータ実装での優位性

| 検証実験 | 目的 | 期待される成果 | 困難度 |

|---|---|---|---|

| ImageNet学習 | 大規模画像分類での検証 | 収束速度10%向上 | 中 |

| LLM事前学習 | 超大規模モデルでの適用 | 必要データ量20%削減 | 高 |

| 強化学習ベンチマーク | Atari/MuJoCo環境 | サンプル効率2倍 | 中 |

| 量子シミュレーション | 量子優位性の検証 | 古典超越の実証 | 非常に高 |

まとめ:機械学習の第一原理が明らかになった歴史的瞬間

本研究の3つの革命的貢献

1. 統一理論の確立

教師あり学習、生成モデル、強化学習という独立に発展してきた3大パラダイムを、物理学の最小作用原理という単一の枠組みで統一。機械学習に「第一原理」が誕生しました。

2. 実用アルゴリズムの理論的基盤

AdamやRMSpropといった現代の標準的最適化器が、経験則ではなくラグランジアン力学から厳密に導出できることを証明。「なぜ機能するのか」の根本理解を提供。

3. 新研究領域の開拓

情報理論、物理学、機械学習を融合した新分野「学習の物理学(Physics of Learning)」を創出。今後数十年の研究方向性を示唆。

AI研究者・実務者への5つの示唆

1. アルゴリズム選択の指針

物理的解釈により、タスクの性質に応じた最適なアルゴリズム選択が理論的に可能に。

2. ハイパーパラメータの物理的意味

学習率やモーメント係数を、質量や摩擦係数として理解することで、直感的なチューニングが可能。

3. データ効率性の重視

計算効率だけでなく、サンプル効率(最小サンプル原理)を意識した設計が重要。

4. 理論と実践の架橋

物理法則という確固たる理論基盤の上に、実用的なシステムを構築できる時代へ。

5. 学際的アプローチの価値

物理学、数学、情報科学の融合が、ブレークスルーを生む典型例。

結論:

本論文は、機械学習が「経験的な試行錯誤」から「物理法則に基づく演繹的科学」へと進化する転換点を示しています。

ニュートンが運動法則を定式化し、古典力学を確立したように、Siyuan GuoとBernhard Schölkopfは「学習の物理法則」を定式化しました。

この研究は、AI研究の歴史において、ニュートン『プリンキピア』に匹敵する記念碑的業績となる可能性を秘めています。

次のステップ:理論を実践へ

研究者・開発者が今すぐできること:

- 📚 論文精読:arXiv:2509.21049を詳細に研究

- 🧪 実験的検証:自身のタスクで物理法則ベース手法を試験

- 💡 新アルゴリズム開発:他の物理原理(熱力学、統計力学)の応用を探索

- 🤝 学際的協力:物理学者との共同研究を推進

- 📢 知識共有:コミュニティでの議論と知見の蓄積

参考文献:

- Siyuan Guo, Bernhard Schölkopf. “Physics of Learning: A Lagrangian perspective to different learning paradigms.” arXiv:2509.21049, 2025.

- Richard Feynman. “The Principle of Least Action.” The Feynman Lectures on Physics, Vol. 2, 1964.

- Shun-ichi Amari. “Information Geometry and Its Applications.” Springer, 2016.

- Karl Friston. “The free-energy principle: a unified brain theory?” Nature Reviews Neuroscience, 2010.

関連記事:

【AI懐疑論の三位一体】Bitter Lesson提唱者サットンまでスケーリング限界を認めた歴史的転換

【Claude Sonnet 4革命】100万トークンコンテキストでAI開発が変わる完全ガイド

【Factory CLI完全ガイド】カスタムドロイドで開発効率3倍:4ヶ月を3.5日にした移行事例

コメント